|

|

| J Korean Ophthalmol Soc > Volume 64(8); 2023 > Article |

|

ĻĄŁļ¼Ėņ┤łļĪØ

ļ¬®ņĀü

ļ│Ė ņŚ░ĻĄ¼ļŖö Ļ░üĻ░üņØś ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢśļ®┤ņä£ ņ┤¼ņśüĒĢ£ ņŚ¼ļ¤¼ ņןņØś ņĢłĻĄ¼ ņé¼ņ¦äņØä ĒĢ£ ņןņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņ£╝ļĪ£ Ļ▓░ĒĢ®ĒĢśļŖö ņāłļĪ£ņÜ┤ ņØĖĻ│Ąņ¦ĆļŖź ĻĖ░ļ░ś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņ×ÉļÅÖ Ļ▓░ĒĢ® ĒöäļĪ£ĻĘĖļש(HydraVersion)ņØä ņĀ£ņĢłĒĢśĻ│Āņ×É ĒĢ£ļŗż. ļśÉĒĢ£ HydraVersionņØś ņĀĢĒÖĢļÅäņÖĆ ņåīņÜö ņŗ£Ļ░äņØä ĻĖ░ņĪ┤ņØś ĒīīņøīĒżņØĖĒŖĖ(PowerPoint)ļź╝ ņØ┤ņÜ®ĒĢśļŖö ņłśņ×æņŚģĻ│╝ ļ╣äĻĄÉĒĢśņŚ¼, HydraVersionņØś ņ£ĀņÜ®ņä▒ņŚÉ ļīĆĒĢ┤ ņĢīņĢäļ│┤Ļ│Āņ×É ĒĢ£ļŗż.

ļīĆņāüĻ│╝ ļ░®ļ▓Ģ

2016ļģä 3ņøöļČĆĒä░ 2022ļģä 6ņøöĻ╣īņ¦Ć ļ│ĖņøÉ ņÖĖļלņŚÉņä£ ņ┤¼ņśüĒĢ£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņżæ 134ļ¬ģņØś ņé¼ņ¦ä 250ņäĖĒŖĖ 2,524ņןņ£╝ļĪ£ ĒøäĒ¢źņĀü ņŚ░ĻĄ¼ļź╝ ņ¦äĒ¢ēĒĢśņśĆļŗż. ĻĘĖņżæ 38ļ¬ģ 74ņäĖĒŖĖ 728ņןņØĆ ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ ņäĖĒŖĖļĪ£ ĻĄ¼ņä▒ĒĢśĻ│Ā, Ļ░üĻ░üņØś ļ░®ļ▓Ģ(HydraVersion/PowerPoint)ņØä ņØ┤ņÜ®ĒĢśņŚ¼ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņāØņä▒ĒĢśļŖöļŹ░ ņåīņÜöļÉ£ ņŗ£Ļ░äņØä ņĖĪņĀĢĒĢśĻ│Ā ņĀĢĒÖĢļÅäļź╝ ĒÅēĻ░ĆĒĢśņŚ¼ ļ╣äĻĄÉ ļČäņäØĒĢśņśĆļŗż.

Ļ▓░Ļ│╝

HydraVersionņØĆ 74ņäĖĒŖĖņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņżæ 71ņäĖĒŖĖ(95.95%)ļź╝ ņĀĢĒÖĢĒĢśĻ▓ī Ļ▓░ĒĢ®ĒĢśņśĆļŗż. HydraVersionņØś ĒÅēĻĘĀ ņåīņÜö ņŗ£Ļ░äņØĆ 2.40 ┬▒ 0.43ņ┤ł, PowerpointņØś ĒÅēĻĘĀ ņåīņÜö ņŗ£Ļ░äņØĆ 255.9 ┬▒ 26.7ņ┤łļĪ£ HydraVersionņØ┤ PowerPointļ│┤ļŗż ļ╣Āļź┤Ļ▓ī ņé¼ņ¦äņØä Ļ▓░ĒĢ®ĒĢśņśĆļŗż(p<0.001).

Ļ▓░ļĪĀ

ĻĘĖļÅÖņĢł ņØ╝ļČĆ ņé¼ņŗ£ ļ░Å ņŗĀĻ▓ĮņĢłĻ│╝ Ēü┤ļ”¼ļŗēņŚÉņä£ļŖö ņŗ£Ļ░ä ļ░Å ņØĖļĀź ļČĆņĪ▒ņØś ņØ┤ņ£ĀļĪ£ ļ¬ćļ¬ćņØś ņĢłĻĄ¼ ņé¼ņ¦äļōżņØ┤ Ļ▓░ĒĢ®ĒĢśņ¦Ć ļ¬╗ĒĢśĻ│Ā ļé▒ņןņ£╝ļĪ£ ļ│┤Ļ┤ĆļÉśņŚłļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ Ļ░£ļ░£ĒĢ£ ĒöäļĪ£ĻĘĖļשņØä ĒåĄĒĢ┤ ļ╣Āļź┤Ļ│Ā ĒÄĖļ”¼ĒĢśĻ▓ī 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņāØņä▒ĒĢ©ņ£╝ļĪ£ņŹ©, ņ¦äļŻī ļ░Å ņŚ░ĻĄ¼ņŚÉ ļ¦ÄņØĆ ļÅäņøĆņØ┤ ļÉĀ Ļ▓āņØ┤ļØ╝ ĻĖ░ļīĆĒĢ£ļŗż.

ABSTRACT

Purpose

This study introduces a new machine learning-based auto-merge program (HydraVersion) that automatically combines multiple ocular photographs into single nine-directional ocular photographs. We compared the accuracy and time required to generate ocular photographs between HydraVersion and PowerPoint.

Methods

This was a retrospective study of 2,524 sets of 250 nine-directional ocular photographs (134 patients) between March 2016 and June 2022. The test dataset comprised 74 sets of 728 photographs (38 patients). We measured the time taken to generate nine-directional ocular photographs using HydraVersion and PowerPoint, and compared their accuracy.

Results

HydraVersion correctly combined 71 (95.95%) of the 74 sets of nine-directional ocular photographs. The average working time for HydraVersion and PowerPoint was 2.40 ┬▒ 0.43 and 255.9 ┬▒ 26.7 seconds, respectively; HydraVersion was significantly faster than PowerPoint (p < 0.001).

Conclusions

Strabismus and neuro-ophthalmology centers are often unable to combine and store photographs, except those of clinically significant cases, because of a lack of time and manpower. This study demonstrated that HydraVersion may facilitate treatment and research because it can quickly and conveniently generate nine-directional ocular photographs.

ļłłņØś ņøĆņ¦üņ×äņØä ĻĖ░ļĪØĒĢśļŖö 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä(nine-directional ocular photography)ņØĆ ņ£ä ņśżļźĖņ¬Į, ņ£ä ņżæņĢÖ, ņ£ä ņÖ╝ņ¬Į, Ļ░ĆņÜ┤ļŹ░ ņśżļźĖņ¬Į, Ļ░ĆņÜ┤ļŹ░ ņżæņĢÖ, Ļ░ĆņÜ┤ļŹ░ ņÖ╝ņ¬Į, ņĢäļל ņśżļźĖņ¬Į, ņĢäļל ņżæņĢÖ, ņĢäļל ņÖ╝ņ¬Į, ņ┤Ø ņĢäĒÖē ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢ£ ņĢłĻĄ¼ ņé¼ņ¦ä(ocular photography) ļōżļĪ£ ĻĄ¼ņä▒ļÉ£ļŗż. ĒĢ£ ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢĀ ļĢī, ņ¢æ ļłłņØ┤ Ļ░ÖņØĆ ļ░®Ē¢źņ£╝ļĪ£ ņøĆņ¦üņØ┤ļŖö ļÅÖĒ¢źņÜ┤ļÅÖ(version)1,2ņØĆ ņÖĖņĢłĻĘ╝ņØś ĻĖ░ļŖźĒĢŁņ¦ä ļśÉļŖö ņĀĆĒĢśņŚÉ ņØśĒĢ┤ ļ╣äņĀĢņāüņĀüņØĖ ļ¬©ņŖĄņØä ļ│┤ņØ╝ ņłś ņ׳ļŖöļŹ░, 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØĆ ņØ┤ ļÅÖĒ¢źņÜ┤ļÅÖņØä ĻĖ░ļĪØĒĢ£ļŗż. ļö░ļØ╝ņä£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØĆ Ļ░üĻ░üņØś ņŻ╝ņŗ£ ļ░®Ē¢źņŚÉ ļö░ļźĖ ļłłņØś ņøĆņ¦üņ×äņØä ĒīīņĢģĒĢśĻ│Ā, ņÖĖņĢłĻĘ╝ņØś ĻĖ░ļŖźĒĢŁņ¦ä ļśÉļŖö ņĀĆĒĢśļź╝ ņ¦äļŗ© ļ░Å ļ│ĆĒÖöļź╝ ņĖĪņĀĢĒĢśļ®░, ņé¼ņŗ£ņłśņłĀ ņĀäņŚÉ ņżæņÜöĒĢ£ ĒÅēĻ░Ć ĒĢŁļ¬®ņ£╝ļĪ£ ĒÖ£ņÜ®ļÉ£ļŗż.

9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņ×æņä▒ĒĢśĻĖ░ ņ£äĒĢ┤ņä£ļŖö Ļ░üĻ░üņØś ņĢłĻĄ¼ ņé¼ņ¦äņØä ņäĀļ│äĒĢśĻ│Ā, ņ×Éļź┤Ļ│Ā, Ēü¼ĻĖ░ļź╝ ņĪ░ņĀłĒĢśĻ│Ā, ļ░░ņŚ┤ĒĢśļŖö Ļ│╝ņĀĢņØ┤ ĒĢäņÜöĒĢśļŗż. ņØ┤ļ¤¼ĒĢ£ Ļ│╝ņĀĢņØĆ ļ¦ÄņØĆ ņŗ£Ļ░äņØ┤ ļōżļ®░, Ļ▓Ćņé¼ņ×ÉņŚÉ ļö░ļźĖ Ļ▓░Ļ│╝ļ¼╝ņØś ĒÄĖņ░©Ļ░Ć Ēü¼ļŗż.3,4 ļśÉĒĢ£ ļŗ©ņł£Ē׳ ņØ┤ļ»Ėņ¦Ćļ¦ī ņ×Éļź┤ļŖö Ļ▓āņØ┤ ņĢäļŗłļØ╝ ņØ┤ļ»Ėņ¦Ćļź╝ ĒÜīņĀäĒĢśĻ│Ā ņ×Éļź┤ļĀżļ®┤, ņČöĻ░ĆļĪ£ ļ¦łņØ┤Ēü¼ļĪ£ ņåīĒöäĒŖĖ ĒīīņøīĒżņØĖĒŖĖ(PowerPoint) ļśÉļŖö ņ¢┤ļÅäļ╣ä ĒżĒåĀņāĄ(Adobe Photoshop)Ļ│╝ Ļ░ÖņØĆ ņĀäļ¼ĖņĀüņØĖ ņØ┤ļ»Ėņ¦Ć ĒÄĖņ¦æ Ēł┤ņØ┤ ĒĢäņÜöĒĢśļŗż. ņØ┤ļ¤¼ĒĢ£ ņØ┤ņ£ĀļĪ£ ņØ╝ļČĆ ļ│æņøÉņŚÉņä£ļŖö ļ¬ćļ¬ćņØś ņĢłĻĄ¼ ņé¼ņ¦äļōżņØ┤ Ļ▓░ĒĢ®ĒĢśņ¦Ć ļ¬╗ĒĢ£ ņ▒äļĪ£ ļé▒ņןņ£╝ļĪ£ ņĀĆņןļÉśĻ│Ā ņ׳ņŚłļŗż.

ĻĖ░Ļ│ä ĒĢÖņŖĄņØä ņØ┤ņÜ®ĒĢ┤ņä£ ņØ┤ļ»Ėņ¦ĆņŚÉņä£ ĒĢ£ Ļ░£ ņØ┤ņāüņØś ļ¼╝ņ▓┤ļź╝ ņ░ŠņĢäņä£ ņ£äņ╣śņÖĆ ņóģļźśļź╝ ņČ£ļĀźĒĢśļŖö ļ¼╝ņ▓┤ ņŗØļ│ä(object detection)ĻĖ░ļ▓ĢņØĆ ņĄ£ĻĘ╝ņŚÉ ļ¦żņÜ░ ļ╣Āļź┤Ļ▓ī ļ░£ņĀäĒĢśĻ│Ā ņ׳ļŗż.5 ļ¼╝ņ▓┤ ņŗØļ│äņØĆ ņ×Éņ£©ņŻ╝Ē¢ē, ļ▓łĒśĖĒīÉ ņŗØļ│ä ļō▒ ļŗżņ¢æĒĢ£ ļČäņĢ╝ņŚÉ ņØæņÜ®ļÉśĻ│Ā ņ׳ļŗż. ņŻ╝ņŗ£ ļ░®Ē¢źņØä ņČöņĀüĒĢśļŖö ĻĖ░ļ▓Ģ ļśÉĒĢ£ ļ╣Āļź┤Ļ▓ī ļ░£ņĀäĒĢśĻ│Ā ņ׳ļŗż.6-8 ņŻ╝ņŗ£ ļ░®Ē¢ź ņČöņĀü ĻĖ░ņłĀļōżņØĆ ņØ┤ļ»Ė ņŚ¼ļ¤¼ ļČäņĢ╝ņŚÉņä£ ĒÖ£ņÜ®ļÉśĻ│Ā ņ׳ļŖöļŹ░, ĻĘĖ ņśłļĪ£ļŖö ņĪĖņØī ņÜ┤ņĀäņØä ņśłļ░®ĒĢśĻ▒░ļéś2 ĻĄÉņ£Ī Ļ│╝ņĀĢņŚÉņä£ ĒĢÖņāØņØś ņ¦æņżæ ņĀĢļÅäļź╝ ĒÅēĻ░Ć9ĒĢśļŖö ļŹ░ ņé¼ņÜ®ĒĢĀ ņłś ņ׳ļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ĻĖ░ņĪ┤ņŚÉ ņĢīļĀżņ¦ä ļ¼╝ņ▓┤ ņŗØļ│ä ĻĖ░ņłĀņŚÉ ĻĖ░ņ┤łĒĢśņŚ¼, ņŚ¼ļ¤¼ ņןņØś ņĢłĻĄ¼ ņé¼ņ¦äņŚÉņä£ ņĢłĻĄ¼ņØś ņ£äņ╣śņÖĆ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ļČäņäØĒĢśļ®░, ņØ┤ļź╝ ĒåĄĒĢ┤ ņĢłĻĄ¼ ņé¼ņ¦äņØä ņ×ÉļÅÖņ£╝ļĪ£ ņäĀļ│äĒĢśĻ│Ā, ĒÜīņĀäĒĢśĻ│Ā, Ēü¼ĻĖ░ļź╝ ņĪ░ņĀĢĒĢśĻ│Ā, ņŻ╝ļ│ĆļČĆļź╝ ņ×Éļź┤Ļ│Ā, ņĀüņĀłĒĢ£ Ēü¼ĻĖ░ņÖĆ ņ£äņ╣śļĪ£ ļ░░ņŚ┤ĒĢśĻ│Ā, Ļ▓░ĒĢ®ĒĢśņŚ¼ ĒĢ£ ņןņØś ņØ┤ļ»Ėņ¦Ćļź╝ ņāØņä▒ĒĢśļŖö ņāłļĪ£ņÜ┤ ņØĖĻ│Ąņ¦ĆļŖź ĻĖ░ļ░ś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņ×ÉļÅÖ Ļ▓░ĒĢ® ĒöäļĪ£ĻĘĖļש(HydraVersion)ņØä ņĀ£ņĢłĒĢśĻ│Āņ×É ĒĢ£ļŗż. ļśÉĒĢ£ ĻĖ░ņĪ┤ņØś PowerPointļź╝ ņØ┤ņÜ®ĒĢśņŚ¼ ņØ┤ļ»Ėņ¦Ćļź╝ ĒÄĖņ¦æĒĢśļŖö ļ░®ļ▓ĢĻ│╝ ļ╣äĻĄÉĒĢśņŚ¼ ņ×ÉļÅÖĒÖö ĒöäļĪ£ĻĘĖļשņŚÉņä£ Ļ░üĻ░ü 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņāØņä▒ĒĢśļŖö ļŹ░ ĒĢäņÜöĒĢ£ ņŗ£Ļ░äĻ│╝ ņĀĢĒÖĢļÅäļź╝ ļ╣äĻĄÉĒĢśņŚ¼ HydraVersionņØś ņ£ĀņÜ®ņä▒ņØä ņĪ░ņé¼ĒĢśĻ│Āņ×É ĒĢ£ļŗż.

2016ļģä 3ņøöļČĆĒä░ 2022ļģä 6ņøöĻ╣īņ¦Ć ņ░ĮņøÉĻ▓ĮņāüĻĄŁļ”ĮļīĆĒĢÖĻĄÉļ│æņøÉ ņĢłĻ│╝ņŚÉņä£ ņ┤¼ņśüĒĢ£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņé¼ņÜ®ĒĢśņśĆļŗż. ļ│Ė ņŚ░ĻĄ¼ļŖö ĒøäĒ¢źņĀü ņØśļ¼┤ĻĖ░ļĪØņØä ļČäņäØĒĢ£ Ēö╝ĒŚśņ×É ļÅÖņØś ļ®┤ņĀ£ ņŚ░ĻĄ¼ļĪ£, ņ░ĮņøÉĻ▓ĮņāüĻĄŁļ”ĮļīĆĒĢÖĻĄÉ ņ×äņāüņŗ£ĒŚś ņ£żļ”¼ņ£äņøÉĒÜī(Institutional Review Board)ņØś ņŖ╣ņØĖņØä ļ░øņĢśņ£╝ļ®░(ņŖ╣ņØĖ ļ▓łĒśĖ: 2022-06-026), ņØśĒĢÖņŚ░ĻĄ¼ņ£żļ”¼ Ļ░ĢļĀ╣ņØĖ ĒŚ¼ņŗ▒ĒéżņäĀņ¢ĖņØä ņżĆņłśĒĢśņśĆļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö PowerPoint (Microsoft Corporation, Redmond, WA, USA)ļź╝ ņØ┤ņÜ®ĒĢśņŚ¼ ņĢłĻĄ¼ ņé¼ņ¦äņØä ĒĢ®ņ╣śļŖö ĻĖ░ņĪ┤ņØś ņłśņ×æņŚģņŚÉ ļ╣äĻĄÉĒĢ£ ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ņĀ£ņŗ£ĒĢśļŖö HydraVersionņØś ņåŹļÅäņÖĆ ņĀĢĒÖĢļÅäļź╝ ļ╣äĻĄÉĒĢśņśĆļŗż.

ņØ┤ļĢī ņåīņÜöļÉ£ ņŗ£Ļ░äņØĆ HydraVersion/PowerPointņØś ņŗ£ņ×æļČĆĒä░ 9ļ░®Ē¢ź ĒĢ®ņä▒ ņé¼ņ¦ä ĒĢśļéśĻ░Ć ņÖäņä▒ļÉĀ ļĢīĻ╣īņ¦ĆņØś ņŗ£Ļ░äņ£╝ļĪ£ ņĀĢņØśĒĢśņśĆļŗż. ņĀĢĒÖĢļÅäļŖö PowerPointļź╝ ņØ┤ņÜ®ĒĢ£ ĻĖ░ņĪ┤ņØś ļ░®ļ▓Ģņ£╝ļĪ£ ņāØņä▒ļÉ£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ĻĖ░ņżĆņ£╝ļĪ£ ĒĢśņŚ¼, 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņ×ÉļÅÖ Ļ▓░ĒĢ® ĒöäļĪ£ĻĘĖļשņØś Ļ▓░Ļ│╝ļ¼╝ņØ┤ ņØ╝ņ╣śĒĢśļŖöņ¦Ć ņŚ¼ļČĆļź╝ 4ļ¬ģņØś ņĢłĻ│╝ņØśņé¼Ļ░Ć ĒĢ©Ļ╗ś ĒÅēĻ░ĆĒĢśņśĆļŗż.

HydraVersionĻ│╝ PowerPointņØś ņłśĒ¢ē ņŗ£Ļ░äņØä ļ╣äĻĄÉĒĢśĻĖ░ ņ£äĒĢ┤ņä£ Kolmogorov-SmirnovļĪ£ ņĀĢĻĘ£ņä▒ Ļ▓ĆņĀĢ Ēøä Wilcoxon signed rank testļź╝ ņé¼ņÜ®ĒĢśņśĆļŗż. ĒåĄĻ│äņĀü ņ£ĀņØśņä▒ņØĆ p<0.05ļĪ£ ņäżņĀĢĒĢśņśĆļŗż.

ņ░ĮņøÉĻ▓ĮņāüĻĄŁļ”ĮļīĆĒĢÖĻĄÉļ│æņøÉ ņåīņĢäņé¼ņŗ£ ļ░Å ņŗĀĻ▓ĮņĢłĻ│╝ ņÖĖļלļź╝ ļ░®ļ¼ĖĒĢ£ ĒÖśņ×É ņżæ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØ┤ ĒĢäņÜöĒĢ£ ĒÖśņ×Éļź╝ ļæÉ ļ¬ģņØś Ļ▓Ćņé¼ņ×ÉĻ░Ć ņ┤¼ņśüĒĢśņśĆļŗż. Ļ▓Ćņé¼ņ×ÉļŖö ĒÖśņ×Éļź╝ ņżĆļ╣äļÉ£ ņØśņ×ÉņŚÉ ņĢēĒśĆ ņ╣┤ļ®öļØ╝ ļĀīņ”łļź╝ ņ¦üņĀæ ļ│┤Ļ▓ī ĒĢśĻ│Ā, Ļ░ĆņÜ┤ļŹ░ ņżæņĢÖ, ņ£ä ņżæņĢÖ, ņ£ä ņÖ╝ņ¬Į, Ļ░ĆņÜ┤ļŹ░ ņÖ╝ņ¬Į, ņĢäļל ņÖ╝ņ¬Į, ņĢäļל ņżæņĢÖ, ņĢäļל ņśżļźĖņ¬Į, Ļ░ĆņÜ┤ļŹ░ ņśżļźĖņ¬Į, ņ£ä ņśżļźĖņ¬Į 9Ļ░£ ļ░®Ē¢źņØä Ļ░üĻ░ü ļ│┤ļÅäļĪØ ņ¦Ćņŗ£ĒĢśņśĆļŗż. ĒÖśņ×ÉĻ░Ć ņĢäļל ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢĀ ļĢīļŖö ļłłĻ║╝ĒÆĆņØ┤ Ļ░üļ¦ē Ļ░Ćņןņ×Éļ”¼ļź╝ Ļ░Ćļ”¼ļŖö Ļ▓āņØä ļ░®ņ¦ĆĒĢśĻĖ░ ņ£äĒĢ┤ ļ│┤ņĪ░ņ×ÉņØś ļÅäņøĆņØä ļ░øņĢä ĒÖśņ×ÉņØś ļłłĻ║╝ĒÆĆņØä ļōżņ¢┤ ņś¼ļĀĖļŗż. ļööņ¦ĆĒäĖņ╣┤ļ®öļØ╝(Canon EOS 100D, Canon Inc, Tokyo, Japan)ļĪ£ ņ┤¼ņśüĒĢśņśĆĻ│Ā, ņ┤¼ņśüļÉ£ ņØ┤ļ»Ėņ¦ĆļōżņØĆ ļō▒ļĪØ ļ▓łĒśĖņÖĆ ņ┤¼ņśüņØ╝ņØä ĻĖ░ņżĆņ£╝ļĪ£ ĒÅ┤ļŹöļ│äļĪ£ ļČäļźśĒĢśņŚ¼, jpgĒīīņØ╝ ĒśĢņŗØņ£╝ļĪ£ ĒĢśļō£ ļööņŖżĒü¼ņŚÉ ņĀĆņןĒĢśņśĆļŗż.

PowerPointļĪ£ ņé¼ņ¦äņØä ņāØņä▒ĒĢśļŖö ļ░®ļ▓ĢņØĆ ļŗżņØīĻ│╝ Ļ░Öļŗż. 9Ļ░£ņØś ļ░®Ē¢źņ£╝ļĪ£ ņ┤¼ņśüļÉ£ ņĢłĻĄ¼ ņé¼ņ¦äļōżņØä ĒĢ£ ņןņØś PowerPoint ņŖ¼ļØ╝ņØ┤ļō£ņŚÉ ļ│Ąņé¼ĒĢśņśĆļŗż. ļæÉ ļłłņØä ņżæņŗ¼ņ£╝ļĪ£ ņØ╝ņĀĢĒĢ£ Ļ░äĻ▓®ņØä ļæÉĻ│Ā ņĀüļŗ╣ĒĢ£ Ēü¼ĻĖ░ļĪ£ ņĢłĻĄ¼ ņé¼ņ¦äļōżņØä ņלļ×Éļŗż. 24├Ś8 cm Ēü¼ĻĖ░ņØś 3├Ś3Ēæ£ļź╝ ņāØņä▒ĒĢśĻ│Ā, ņלļØ╝ļéĖ ņØ┤ļ»Ėņ¦Ćļź╝ ŌĆ£ĻĘĖļ”╝ ļśÉļŖö ņ¦łĻ░É ņ▒äņÜ░ĻĖ░ŌĆØļź╝ ņØ┤ņÜ®ĒĢśņŚ¼ Ļ░üĻ░üņØś ņģĆņŚÉ ļäŻņŚłļŗż.

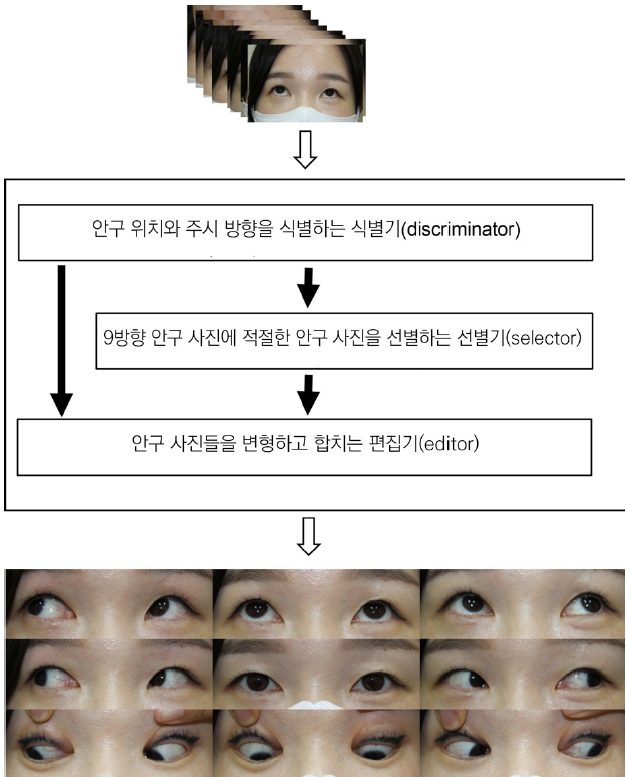

HydraVersionņØĆ ĻĖ░Ļ│ä ĒĢÖņŖĄņØä ņØ┤ņÜ®ĒĢśņŚ¼ ņĢłĻĄ¼ ņé¼ņ¦äņŚÉņä£ ņĢłĻĄ¼ ņ£äņ╣śņÖĆ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ĒĢ┤ņäØĒĢśļŖö ņŗØļ│äĻĖ░(discriminator), ņŻ╝ņŗ£ ļ░®Ē¢źņŚÉ ĻĖ░ņ┤łĒĢśņŚ¼ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņŚÉ ņĀüņĀłĒĢ£ ņĢłĻĄ¼ ņé¼ņ¦äņØä ņäĀļ│äĒĢśļŖö ņäĀļ│äĻĖ░(selector), ņĢłĻĄ¼ ņ£äņ╣śņŚÉ ļö░ļØ╝ ņØ┤ļ»Ėņ¦Ćļź╝ ĒÜīņĀäĒĢśĻ│Ā Ēü¼ĻĖ░ļź╝ ņĪ░ņĀĢĒĢśĻ│Ā ņŻ╝ļ│ĆļČĆļź╝ ņ×Éļź┤Ļ│Ā ņĀüņĀłĒĢ£ Ēü¼ĻĖ░ņÖĆ ņ£äņ╣śļĪ£ ļ░░ņŚ┤ĒĢśĻ│Ā Ļ▓░ĒĢ®ĒĢśņŚ¼ ĒĢ£ ņןņØś ņØ┤ļ»Ėņ¦Ćļź╝ ņāØņä▒ĒĢśļŖö ĒÄĖņ¦æĻĖ░(editor)ļĪ£ ĻĄ¼ņä▒ļÉ£ļŗż(Fig. 1).

ņøÉļ│Ė ņé¼ņ¦äņØś Ēü¼ĻĖ░ļŖö 5,184├Ś3,456 ĒöĮņģĆņØ┤ļŗż. ņøÉļ│Ė ņé¼ņ¦äņØś Ēü¼ĻĖ░Ļ░Ć ļäłļ¼┤ Ēü¼ĻĖ░ ļĢīļ¼ĖņŚÉ, 1/8 Ēü¼ĻĖ░ņØĖ 648├Ś432 ĒöĮņģĆ Ēü¼ĻĖ░ļĪ£ ņČĢņåīĒĢśņśĆļŗż. ņČĢņåīĒĢ£ ņé¼ņ¦äņØĆ OpenCV10ņÖĆ NumPy11ļź╝ ņØ┤ņÜ®ĒĢśņŚ¼ ļ¼┤ņåÉņŗż ņĢĢņČĢ ĒśĢņŗØņØĖ png ĒīīņØ╝ Ēżļ¦Ęņ£╝ļĪ£ ļ│ĆĒÖś ļ░Å ņĀĆņןĒĢśņśĆļŗż.

ĻĖ░Ļ│ä ĒĢÖņŖĄ ņżæņŚÉ ņŗØļ│äĻĖ░ņØś ņä▒ļŖźņØä ļåÆņØ┤ĻĖ░ ņ£äĒĢ┤ ļŹ░ņØ┤Ēä░ ņ”ØĻ░Ģ(data augmentation)ņØä ņŗ£Ē¢ēĒĢśņśĆļŗż. ņØ┤ļź╝ ņ£äĒĢ┤ ņĢłĻĄ¼ ņé¼ņ¦äļōżņØä ļ¼┤ņ×æņ£äņØś Ēü¼ĻĖ░ļĪ£ ņØ┤ļ»Ėņ¦Ćļź╝ ĒÖĢļīĆ ļśÉļŖö ņČĢņåīĒĢ£ ļÆż, ņŻ╝ļ│ĆļČĆļź╝ ņלļØ╝ļé┤Ļ▒░ļéś ņŚ¼ļ░▒ņ£╝ļĪ£ ņ▒äņÜ░ļŖö Ļ│ĄĻ░ä ļĀłļ▓© ļ│ĆĒśĢņØä ņłśĒ¢ēĒĢśņśĆļŗż. ļ¬©ļōĀ ļŹ░ņØ┤Ēä░ ņ”ØĻ░ĢņØĆ TensorFlow12ņŚÉ ļé┤ĒżļÉ£ ĒĢ©ņłśļōżņØä ņØ┤ņÜ®ĒĢ┤ņä£ ņłśĒ¢ēĒĢśņśĆļŗż.

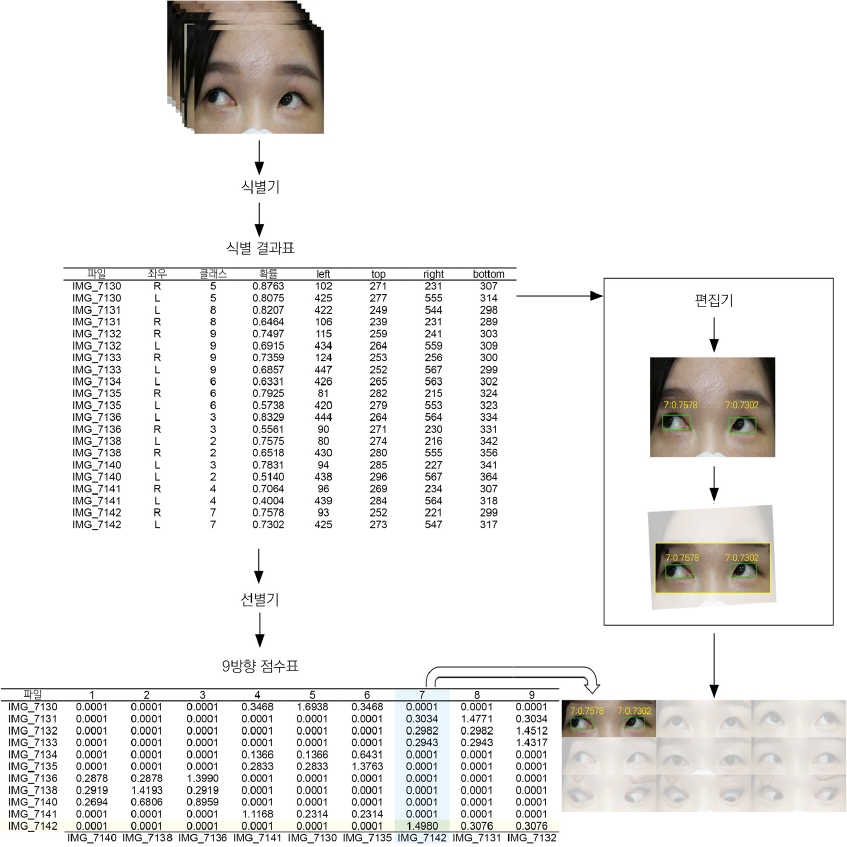

ĻĖ░Ļ│ä ĒĢÖņŖĄņŚÉņä£ Ēü┤ļלņŖżļ×Ć, ĒīÉļ│äĒĢśĻ│Āņ×É ĒĢśļŖö ļ¼╝ņ▓┤(object)ņØś ņóģļźśļź╝ ļ¦ÉĒĢ£ļŗż. ņÜ░ļ”¼ļŖö ņĢłĻĄ¼ ņé¼ņ¦äņŚÉņä£ ĒŖ╣ņĀĢĒĢ£ ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢśļŖö ņĢłĻĄ¼ ņØ┤ļ»Ėņ¦Ćļź╝ ņ░ŠĻ│Āņ×É ĒĢśņśĆĻ│Ā, Ļ░üĻ░üņØś ņĢłĻĄ¼ ņØ┤ļ»Ėņ¦ĆņŚÉ ŌĆ£1ŌĆØņŚÉņä£ ŌĆ£9ŌĆØĻ╣īņ¦Ć Ēü┤ļלņŖżļź╝ ļČĆņŚ¼ĒĢśņśĆļŗż(Fig. 2). Ļ░ü ņł½ņ×ÉĻ░Ć ņØśļ»ĖĒĢśļŖö ņŻ╝ņŗ£ ļ░®Ē¢źņØĆ Ēéżļ│┤ļō£ ņł½ņ×É Ēī©ļō£ņÖĆ ļÅÖņØ╝ĒĢśĻ▓ī ņäżņĀĢĒĢśņśĆļŗż. ņśłļź╝ ļōżņ¢┤ ŌĆ£1ŌĆØņØĆ ņśżļźĖņ¬Į ņĢäļלļź╝ ņŻ╝ņŗ£ĒĢśļŖö ļłłņØ┤Ļ│Ā, ŌĆ£3ŌĆØņØĆ ņÖ╝ņ¬Į ņĢäļלļź╝ ņŻ╝ņŗ£ĒĢśļŖö ļłłņØ┤ļŗż. ļ¦īņĢĮ ĒĢ£ ņé¼ņ¦äņŚÉņä£ ņÜ░ņĢłĻ│╝ ņóīņĢłņØ┤ ļŗżļźĖ ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢśļ®┤, ļæÉ ļłłņØĆ ņä£ļĪ£ ļŗżļźĖ Ēü┤ļלņŖżļź╝ Ļ░Ćņ¦ł ņłś ņ׳ļŗż.

ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖļŖö ņśżĒöł ņåīņŖż ĒöäļĪ£ĻĘĖļשņØĖ Computer Vision Annotation Tool (CVAT; https://cvat.org)ļź╝ ņØ┤ņÜ®ĒĢśņŚ¼ ņāØņä▒ĒĢśņśĆļŗż. ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖļź╝ ĻĄ¼ņä▒ĒĢśļŖö Ļ░üĻ░üņØś ņĢłĻĄ¼ ņé¼ņ¦äņŚÉ ļīĆĒĢśņŚ¼, ņĢłĻĄ¼ņØś ņ£äņ╣śļź╝ ņ¦üņé¼Ļ░üĒśĢņ£╝ļĪ£ Ēæ£ĻĖ░ĒĢśĻ│Ā ņŻ╝ņŗ£ ļ░®Ē¢źņØä Ēü┤ļלņŖżļĪ£ ļØ╝ļ▓©ļ¦üĒĢśņśĆļŗż(Fig. 2). ņĢłĻĄ¼ņØś ņ£äņ╣śļŖö Ļ░ĆļĪ£ļĪ£ ņĢłĻĄ¼ņØś ļé┤ņĢłĻ░üņŚÉņä£ ņÖĖņĢłĻ░üĻ╣īņ¦Ć, ņäĖļĪ£ļĪ£ ņ£ŚļłłĻ║╝ĒÆĆ ņĀĢņĀÉņŚÉņä£ ņĢäļלļłłĻ║╝ĒÆĆ ņĀĢņĀÉĻ╣īņ¦ĆļĪ£ ņĀĢņØśĒĢśņśĆļŗż. ņĄ£ņóģņĀüņ£╝ļĪ£ ĒĢÖņŖĄņÜ® ļŹ░ņØ┤Ēä░ņģŗņØä ņāØņä▒ĒĢśĻĖ░ ņ£äĒĢ┤, CVATļź╝ ņØ┤ņÜ®ĒĢśņŚ¼ ļØ╝ļ▓©ļ¦üļÉ£ ņØ┤ļ»Ėņ¦ĆļōżņØä Tfrecord ĒīīņØ╝ ĒśĢņŗØņ£╝ļĪ£ ļ│ĆĒÖśĒĢśņśĆļŗż.

ļ│Ė ņŚ░ĻĄ¼ņØś ņŗØļ│äĻĖ░ļŖö 2019ļģäņŚÉ Ļ│ĄĻ░£ļÉśņ¢┤ ĻĘĖ ņä▒ļŖźņØ┤ ņØĖņĀĢļÉ£ EfficientDet13ņØä ņØ┤ņÜ®ĒĢśņśĆļŗż. ĻĄ¼ņ▓┤ņĀüņØĖ ļ¬©ļŹĖņØĆ GoogleņŚÉņä£ ņśłņŗ£ĒĢ£ ņĮöļō£(https://github.com/google/automl) ņżæ EfficientDet D7 ļ¬©ļŹĖņØä ņØ╝ļČĆ ņłśņĀĢĒĢśņŚ¼ ņé¼ņÜ®ĒĢśņśĆļŗż.

EfficientDet D7 ļ¬©ļŹĖņØĆ EfficientDetņŚÉņä£ ņĀ£ņŗ£ĒĢ£ ņŚ¼ļ¤¼ ļ¬©ļŹĖ ņżæ Ļ░Ćņן Ēü¼ĻĖ░Ļ░Ć Ēü¼Ļ│Ā Ļ░Ćņן ņä▒ļŖźņØ┤ ņÜ░ņłśĒĢ£ ļ¬©ļŹĖņØ┤ļŗż. Backbornņ£╝ļĪ£ EfficientNet B714ņØä ņØ┤ņÜ®ĒĢśļ®░, ņĢĮ 5ņ▓£ļ¦ī Ļ░£ņØś ĒĢÖņŖĄ ļ│Ćņłśļź╝ Ļ░Ćņ¦ĆĻ│Ā ņ׳ļŗż. ĒĢÖņŖĄ ļ│ĆņłśĻ░Ć ļ¦ÄĻ│Ā ļ╣äĻĄÉņĀü ļŖÉļ”¼ņ¦Ćļ¦ī, ļ¦żņÜ░ ņĀĢĒÖĢĒĢ£ Ļ▓░Ļ│╝ļź╝ ļ│┤ņŚ¼ņżĆļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ EfficientDet D7ņØä ĒĢÖņŖĄņŗ£ĒéżĻĖ░ ņ£äĒĢ┤ ļ░░ņ╣ś(batch)Ēü¼ĻĖ░ļŖö 4ļĪ£ ĒĢśņśĆĻ│Ā, ņ┤Ø 200 ņŚÉĒÅŁ(epochs)ļ¦īĒü╝ ĒĢÖņŖĄņØä ņłśĒ¢ēĒĢśņśĆļŗż. Intel┬« CoreŌäó i9-10980XEņÖĆ GeForce RTX 3090ņØä ņØ┤ņÜ®ĒĢśņśĆĻ│Ā ņ┤Ø 32ņŗ£Ļ░äņØś ĒĢÖņŖĄ ņŗ£Ļ░äņØ┤ ņåīņÜöļÉśņŚłļŗż.

ĻĖ░Ļ│äĒĢÖņŖĄņØ┤ ļüØļé£ ņŗØļ│äĻĖ░ļŖö 9ņן ņØ┤ņāüņØś ņĢłĻĄ¼ ņé¼ņ¦äļōżņØä ņ×ģļĀźļ░øņĢä ņĢłĻĄ¼ņØś ņ£äņ╣ś, Ēü┤ļלņŖżņÖĆ ņØ┤ņŚÉ ļīĆĒĢ£ ĒÖĢļźĀ(score)ņØä ĒżĒĢ©ĒĢśļŖö ņŗØļ│ä Ļ▓░Ļ│╝Ēæ£ļź╝ ņČ£ļĀźĒĢ£ļŗż(Fig. 2).

ņäĀļ│äĻĖ░ļŖö ņŗØļ│äĻĖ░ļĪ£ļČĆĒä░ ņŗØļ│ä Ļ▓░Ļ│╝Ēæ£ļź╝ ļ░øņĢä 9ļ░®Ē¢ź ņĀÉņłśĒæ£ļź╝ ņāØņä▒ĒĢ£ļŗż(Fig. 2). 9ļ░®Ē¢ź ņĀÉņłśĒæ£ļŖö Ļ░üĻ░üņØś ņĢłĻĄ¼ ņé¼ņ¦äņØ┤ ĒŖ╣ņĀĢĒĢ£ ļ░®Ē¢źņØś ļÅÖĒ¢źņÜ┤ļÅÖņŚÉ ņ¢╝ļ¦łļéś ņĀüņĀłĒĢ£ņ¦Ć ņĀÉņłśļĪ£ Ēæ£ĒśäĒĢ£ Ēæ£ņØ┤ļŗż. ņØ┤Ēøä ļŗżņØīĻ│╝ Ļ░ÖņØ┤ Ļ░Ćņן ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ ļ¬ģĒÖĢĒĢ£ ņł£ņä£ļīĆļĪ£ ņĢłĻĄ¼ ņé¼ņ¦äņØä Ļ│ĀļźĖļŗż. ņÜ░ņäĀ 9ļ░®Ē¢ź ņĀÉņłśĒæ£ņŚÉņä£ Ļ░Ćņן ļåÆņØĆ Ļ░ÆņØä ņ░ŠļŖöļŗż. Fig. 2ņŚÉņä£ ŌĆ£IMG_7130ŌĆØņØ┤ Ēü┤ļלņŖż ŌĆ£5ŌĆØņŚÉņä£ Ļ░Ćņן ļåÆņØĆ Ļ░ÆņØĖ ŌĆ£1.6938ŌĆØņØä Ļ░Ćņ¦ĆĻ│Ā ņ׳ĻĖ░ ļĢīļ¼ĖņŚÉ ŌĆ£IMG_7130ŌĆØņØä Ēü┤ļלņŖż ŌĆ£5ŌĆØņŚÉ ļ░░ņĀĢĒĢ£ļŗż. ļŗżņØīņ£╝ļĪ£ ļåÆņØĆ Ļ░ÆņØĆ ŌĆ£IMG_7142ŌĆØĻ░Ć Ēü┤ļלņŖż ŌĆ£7ŌĆØņŚÉņä£ ŌĆ£1.4980ŌĆØņØä Ļ░Ćņ¦ĆĻ│Ā ņ׳ļŗż. ņØ┤ļĢī ŌĆ£IMG_7142ŌĆØ ļŗżļźĖ Ēü┤ļלņŖżņŚÉ ļ░░ņĀĢļÉśņ¢┤ ņ׳Ļ▒░ļéś Ēü┤ļלņŖż ŌĆ£7ŌĆØņŚÉ ļŗżļźĖ ņØ┤ļ»Ėņ¦ĆĻ░Ć ļ░░ņĀĢļÉśņ¢┤ ņ׳ļŖöņ¦Ć ĒÖĢņØĖĒĢ£ļŗż. ļ¦īņĢĮ ņØ┤ļ»Ėņ¦Ćļéś Ēü┤ļלņŖż ņżæ ĒĢśļéśļØ╝ļÅä ļŗżļźĖ Ļ││ņŚÉ ļ░░ņĀĢļÉśņ¢┤ ņ׳ņŚłļŗżļ®┤ ļŗżņØī ņł£ņä£ļĪ£ ļäśņ¢┤Ļ░ĆĻ│Ā, ņĢäļŗłļØ╝ļ®┤ ĒĢ┤ļŗ╣ ņØ┤ļ»Ėņ¦Ćļź╝ ĒĢ┤ļŗ╣ Ēü┤ļלņŖżņŚÉ ļ░░ņĀĢĒĢ£ļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ŌĆ£IMG_7142ŌĆØĻ░Ć ņØ┤ļ»Ėņ¦ĆņÖĆ Ēü┤ļלņŖż ļæś ļŗż ļ░░ņĀĢļÉśņ¢┤ ņ׳ņ¦Ć ņĢŖņĢśĻĖ░ ļĢīļ¼ĖņŚÉ ŌĆ£IMG_7142ŌĆØļź╝ Ēü┤ļלņŖż ŌĆ£7ŌĆØņŚÉ ļ░░ņĀĢĒĢśņśĆļŗż. Ļ░ÖņØĆ ļ░®ļ▓ĢņØä 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØś ļ¬©ļōĀ ļ░®Ē¢źņŚÉ ņĢłĻĄ¼ ņé¼ņ¦äņØ┤ ļ░░ņĀĢļÉĀ ļĢīĻ╣īņ¦Ć ļ░śļ│ĄĒĢ£ļŗż.

ĒÄĖņ¦æĻĖ░ļŖö ņŗØļ│äĻĖ░ņŚÉņä£ ņŗØļ│ä Ļ▓░Ļ│╝Ēæ£ļź╝, ņäĀļ│äĻĖ░ļĪ£ļČĆĒä░ 9ļ░®Ē¢ź ņĀÉņłśĒæ£ļź╝ ļ░øņĢä 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņāØņä▒ĒĢ£ļŗż. ĒÄĖņ¦æĻĖ░ļŖö ņĢłĻĄ¼ ņé¼ņ¦äļōżņØä ĻĘ£Ļ▓®ĒÖöļÉ£ ĒśĢĒā£ļĪ£ ļ│ĆĒÖśĒĢ£ļŗż. ņÜ░ņäĀ ĒÄĖņ¦æĻĖ░ļŖö ņĢłĻĄ¼ ņé¼ņ¦äĻ│╝ ņŗØļ│ä Ļ▓░Ļ│╝Ēæ£ņØś ņĢłĻĄ¼ ņ£äņ╣śļź╝ ņØ┤ņÜ®ĒĢ┤ ļæÉ ņĢłĻĄ¼ņØś ņżæņŗ¼ņØä ņŚ░Ļ▓░ĒĢśļŖö ņäĀņØä ĻĖŗļŖöļŗż. ņØ┤ ņäĀņØ┤ ņłśĒÅēņØ┤ ļÉśļÅäļĪØ ņĢłĻĄ¼ ņé¼ņ¦äņØä ĒÜīņĀäĒĢ£ļŗż. ņØ┤Ēøä ļæÉ ņżæņŗ¼ņØä ņŚ░Ļ▓░ĒĢśļŖö ņäĀņØś ĻĖĖņØ┤Ļ░Ć ļ»Ėļ”¼ ņäżņĀĢļÉ£ ĻĖĖņØ┤Ļ░Ć ļÉśļÅäļĪØ ņØ┤ļ»Ėņ¦Ć Ēü¼ĻĖ░ļź╝ ņĪ░ņĀĢĒĢ£ļŗż. ņØ┤Ēøä ļ»Ėļ”¼ ņäżņĀĢļÉ£ ņØ┤ļ»Ėņ¦Ć ņŚ¼ļ░▒ ļ╣äņ£©Ļ│╝ ņóģĒÜĪļ╣äņŚÉ ļ¦×Ļ▓ī ļČłĒĢäņÜöĒĢ£ ņŻ╝ļ│ĆļČĆļź╝ ņלļØ╝ļéĖļŗż. ņØ┤Ēøä ĒÄĖņ¦æĻĖ░ļŖö ņäĀļ│äĻĖ░ņŚÉņä£ ņĀäļŗ¼ļ░øņØĆ 9ļ░®Ē¢ź ņĀÉņłśĒæ£ļź╝ ĻĘ╝Ļ▒░ļĪ£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØś Ļ░ü ņ£äņ╣śņŚÉ ĒÄĖņ¦æĒĢ£ ņØ┤ļ»Ėņ¦Ćļź╝ ļ░░ņŚ┤ĒĢśĻ│Ā, ĒĢ®ņ│É ĒĢ£ ņןņØś ņØ┤ļ»Ėņ¦Ćļź╝ ņāØņä▒ĒĢ£ļŗż(Fig. 2).

ļ│Ė ņŚ░ĻĄ¼ļŖö Python ļ▓äņĀä 3.7.9ļź╝ ņé¼ņÜ®ĒĢśņśĆļŗż. EfficientDet ļ¬©ļŹĖņØĆ TensorFlow12 2.4.1, Keras 2.4.3, OpenCV10 4.5.1.48, NumPy11 1.19.5ļĪ£ ĻĄ¼ņä▒ļÉśņŚłļŗż. ĒģīņŖżĒŖĖ ņäĖĒŖĖņØś ņĀĢĒÖĢļÅäņÖĆ ņåīņÜö ņŗ£Ļ░äņ£╝ļĪ£ ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ņĀ£ņŗ£ĒĢ£ ļ¬©ļŹĖņØś ņä▒ļŖźņØä ĒÅēĻ░ĆĒĢśņśĆļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉ ņé¼ņÜ®ļÉ£ CPUļŖö Intel┬« CoreŌäó i9-10980XEņØ┤Ļ│Ā GPUļŖö GeForce RTX 3090 ĻĘĖļלĒöĮ ņ╣┤ļō£ņØ┤ļŗż. ĒåĄĻ│ä ļČäņäØņØĆ Microsoft Windows Ēöīļ×½ĒÅ╝ņÜ® SPSS ĒåĄĻ│ä ņåīĒöäĒŖĖņø©ņ¢┤ ļ▓äņĀä 24.0 (SPSS, IBM, Chicago, IL, USA)ņØä ņé¼ņÜ®ĒĢśņŚ¼ ĒÅēĻ░Ć ļŹ░ņØ┤Ēä░ņäĖĒŖĖņØś Ļ▓░Ļ│╝ļź╝ ļČäņäØĒĢśņśĆļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉ ņé¼ņÜ®ĒĢ£ ņĢłĻĄ¼ ņé¼ņ¦äļōżņØĆ ļō▒ļĪØļ▓łĒśĖ, ņ┤¼ņśüņØ╝, ņ¦łĒÖśļ¬ģņ£╝ļĪ£ ĒÅ┤ļŹöļ│äļĪ£ ĻĄ¼ļČäļÉśņ¢┤ ņ׳ņŚłļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ĒĢ£ ĒÖśņ×ÉĻ░Ć ņŚ¼ļ¤¼ ļéĀņ¦£ņŚÉ ļé┤ņøÉĒĢśņŚ¼ ņ┤¼ņśüĒĢ£ Ļ▓ĮņÜ░, ļéĀņ¦£ļ│äļĪ£ ĻĄ¼ļČäĒĢ┤ņä£ ņäĖĒŖĖļź╝ ĻĄ¼ņä▒ĒĢśņśĆļŗż. ļśÉĒĢ£ ĒŖ╣ņĀĢ ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢśļŖö ņé¼ņ¦äņØ┤ ļæÉņן ņØ┤ņāüņØ┤ņ¢┤ņä£ 10ņן ņØ┤ņāüņØś ņé¼ņ¦äņØ┤ ĒĢ£ ņäĖĒŖĖļź╝ ĻĄ¼ņä▒ĒĢśļŹöļØ╝ļÅä, ņé¼ņ¦äņØä Ļ│©ļØ╝ļé┤ņ¦Ć ņĢŖĻ│Ā ļ¬©ļōĀ ņé¼ņ¦äņØä ņé¼ņÜ®ĒĢśņśĆļŗż. ļé┤ņé¼ņŗ£, ņÖĖņé¼ņŗ£, ļ¦łļ╣äņé¼ņŗ£, ņĀ£ĒĢ£ņé¼ņŗ£ Ļ░üĻ░üņŚÉņä£ HydraVersionņØś ņä▒ļŖźņØä ĒÖĢņØĖĒĢśĻĖ░ ņ£äĒĢ┤ ļé┤ņé¼ņŗ£, Ļ░äĒŚÉņÖĖņé¼ņŗ£, ļ¦łļ╣äņé¼ņŗ£, Ļ░æņāüņäĀņĢł ļ│æņ”ØņØä ļīĆņāüĻĄ░ņ£╝ļĪ£ ņĀĢĒĢśņśĆļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ļé┤ņé¼ņŗ£ 29ļ¬ģ 43ņäĖĒŖĖ 458ņן, Ļ░äĒŚÉņÖĖņé¼ņŗ£ 47ļ¬ģ 90ņäĖĒŖĖ 914ņן, ļ¦łļ╣äņé¼ņŗ£ 45ļ¬ģ 92ņäĖĒŖĖ 911ņן, Ļ░æņāüņäĀņĢłļ│æņ”Ø 13ļ¬ģ 25ņäĖĒŖĖ 241ņן, ņ┤Ø 134ļ¬ģ 250ņäĖĒŖĖ 2524ņןņ£╝ļĪ£ ņŚ░ĻĄ¼ļź╝ ņ¦äĒ¢ēĒĢśņśĆļŗż. ļīĆņāüĻĄ░ņØś ĒÅēĻĘĀ ļéśņØ┤ļŖö 26.6 ┬▒ 22.5ņäĖņØ┤Ļ│Ā, ņä▒ļ╣äļŖö ļé©ņ×É 65ļ¬ģ, ņŚ¼ņ×É 69ļ¬ģņØ┤ņŚłļŗż. ņĀäņ▓┤ ļīĆņāüĻĄ░ ņżæ ņ×äņØśļĪ£ 70%ļŖö ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖļĪ£ ņé¼ņÜ®ĒĢśņśĆņ£╝ļ®░, 30%ļŖö ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖļĪ£ ņĀĢĒĢśņśĆļŗż. ņĄ£ņóģņĀüņ£╝ļĪ£ ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖļŖö 96ļ¬ģ 176ņäĖĒŖĖ 1,796ņןņ£╝ļĪ£ ĻĄ¼ņä▒ĒĢśņśĆĻ│Ā, 38ļ¬ģ 74ņäĖĒŖĖ 728ņןņØĆ ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖļĪ£ ĻĄ¼ņä▒ĒĢśņśĆļŗż.

CVATļź╝ ņØ┤ņÜ®ĒĢ┤ ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖņŚÉ ĒżĒĢ©ļÉ£ Ļ░ü ņé¼ņ¦äņŚÉ ņĢłĻĄ¼ņØś ņ£äņ╣śņÖĆ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ļØ╝ļ▓©ļ¦üĒĢśņśĆļŗż. ļØ╝ļ▓©ļ¦üļÉ£ ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖļĪ£ HydraVersionņØä ĒøłļĀ©ņŗ£Ēé© Ēøä, HydraVersionņØś ņä▒ļŖźņØä ĒÅēĻ░ĆĒĢśņśĆļŗż. ļ©╝ņĀĆ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ĒĢ®ņä▒ĒĢśĻĖ░ ņĀäņØś ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖ 728ņןņØś Ļ░£ļ│ä ņé¼ņ¦äņŚÉņä£ HydraVersionņØ┤ ņÜ░ņĢłĻ│╝ ņóīņĢłņØś ņŻ╝ņŗ£ ļ░®Ē¢źņØä ļ¦×Ļ▓ī ĒīÉļÅģĒĢśņśĆļŖöņ¦Ć ĒÖĢņØĖĒĢśņśĆļŗż. ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖļŖö Ļ░ü ņ¦łĒÖśļ│äļĪ£ ļé┤ņé¼ņŗ£ 8ļ¬ģ 12ņäĖĒŖĖ 116ņן, ņÖĖņé¼ņŗ£ 13ļ¬ģ 28ņäĖĒŖĖ 290ņן, ļ¦łļ╣äņé¼ņŗ£ 11ļ¬ģ 27ņäĖĒŖĖ 246ņן, Ļ░æņāüņäĀņĢłļ│æņ”Ø ĒÖśņ×É 4ļ¬ģ 7ņäĖĒŖĖ 76ņןņ£╝ļĪ£ ĻĄ¼ņä▒ĒĢśņśĆļŗż. HydraVersionņØĆ 728ņןņØś ņé¼ņ¦ä ņżæ 709ņן(97.39%)ņØä ņĀĢĒÖĢĒĢśĻ▓ī ļØ╝ļ▓©ļ¦üĒĢśņśĆļŗż. ņ¦łĒÖśļ¬ģņŚÉ ļö░ļźĖ ņĀĢĒÖĢļÅäļŖö ļé┤ņé¼ņŗ£ 98.28%, ņÖĖņé¼ņŗ£ 96.21%, ļ¦łļ╣äņé¼ņŗ£ 99.59%, Ļ░æņāüņäĀņĢłļ│æņ”Ø 93.42%ņśĆļŗż(Table 1). ĒīÉļÅģņŚÉ ņśżļźśĻ░Ć ļ░£ņāØĒĢ£ ņøÉņØĖņØĆ ĒśæņĪ░Ļ░Ć ļČĆņĪ▒ĒĢ£ ĒÖśņ×ÉņŚÉņä£ ļłłĻ║╝ĒÆĆņØ┤ ļÅÖĻ│ĄņØä Ļ░Ćļ”¼Ļ▒░ļéś ņé¼ņ¦äņØś ņ┤łņĀÉņØ┤ ļ¦×ņ¦Ć ņĢŖņĢä ļÅÖĻ│ĄņØä ņ░ŠĻĖ░ ņ¢┤ļĀżņÜ┤ Ļ▓ĮņÜ░ņśĆļŗż.

ļŗżņØīņ£╝ļĪ£ Ļ░üĻ░üņØś ņ¦łĒÖśņŚÉ ļīĆĒĢ£ HydraVersionņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ĒĢ®ņä▒ ņåŹļÅäņÖĆ ņĀĢĒÖĢļÅäļź╝ ĒÅēĻ░ĆĒĢśĻĖ░ ņ£äĒĢ┤, ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖļź╝ ņØ┤ņÜ®ĒĢ┤ņä£ HydraVersionĻ│╝ PowerPointļĪ£ Ļ░üĻ░ü 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņāØņä▒ĒĢśņśĆļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ Ļ░£ļ░£ĒĢ£ HydraVersionņØĆ 74ņäĖĒŖĖņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņżæ, 71ņäĖĒŖĖ(95.95%)ļź╝ ņĀĢĒÖĢĒĢśĻ▓ī Ļ▓░ĒĢ®ĒĢśņśĆļŗż. ņ¦łĒÖśļ¬ģņŚÉ ļö░ļźĖ ņĀĢĒÖĢļÅäļŖö, ļé┤ņé¼ņŗ£ 100%, ņÖĖņé¼ņŗ£ 92.86%, ļ¦łļ╣äņé¼ņŗ£ 96.30%, Ļ░æņāüņäĀņĢłļ│æņ”Ø 100% ņśĆļŗż(Table 1). ņÖĖņé¼ņŗ£ 2ņäĖĒŖĖ, ļ¦łļ╣äņé¼ņŗ£ 1ņäĖĒŖĖņŚÉņä£ ņé¼ņ¦ä ĒĢ®ņä▒ņŚÉ ņśżļźśĻ░Ć ļ░£ņāØĒĢśņśĆļŖöļŹ░, ĻĘĖ ņøÉņØĖņØĆ ļŗżņØīĻ│╝ Ļ░Öļŗż. ļæÉ ņäĖĒŖĖļŖö ĒśæņĪ░Ļ░Ć ļČĆņĪ▒ĒĢ£ ņ¢┤ļ”░ ĒÖśņĢäņŚÉņä£ ļłłĻ║╝ĒÆĆņØ┤ ļÅÖĻ│ĄņØä Ļ░ĆļĀĖĻ│Ā, ĒĢ£ ņäĖĒŖĖļŖö ņé¼ņ¦äņØś ņ┤łņĀÉņØ┤ ļ¦×ņ¦Ć ņĢŖņĢśļŗż. ņØ┤ļĀćĻ▓ī ņé¼ņ¦äņØś ņ¦łņØ┤ ļ¢©ņ¢┤ņ¦ĆļŖö Ļ▓ĮņÜ░, ĒöäļĪ£ĻĘĖļשņØ┤ ņĢłĻĄ¼ļź╝ ņ░Šņ¦Ć ļ¬╗ĒĢśĻ│Ā ņלļ¬╗ļÉ£ ņØ┤ļ»Ėņ¦Ćļź╝ ņāØņä▒ĒĢśņśĆļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ Ļ░£ļ░£ĒĢ£ HydraVersionĻ│╝ PowerPointļĪ£ ņ×æņŚģĒ¢łņØä ļĢīņØś ņåīņÜö ņŗ£Ļ░äņØä ļ╣äĻĄÉĒĢśņśĆļŗż. ļæÉ ĻĘĖļŻ╣ ļ¬©ļæÉ ņĀĢĻĘ£ņä▒ņØä ļ¦īņĪ▒ĒĢśņ¦Ć ņĢŖņĢä(HydraVersion: p<0.001, PowerPoint: p=0.015), ļ╣äļ¬©ņłś Ļ▓ĆņĀĢņØĖ Wilcoxon signed rank testļź╝ ņŗ£Ē¢ēĒĢśņśĆļŗż. Hydra-VersionņØś ĒÅēĻĘĀ ņåīņÜö ņŗ£Ļ░äņØĆ 2.40 ┬▒ 0.43ņ┤ł, PowerPointņØś ĒÅēĻĘĀ ņåīņÜö ņŗ£Ļ░äņØĆ 255.9 ┬▒ 26.7ņ┤łļĪ£, HydraVersionņØ┤ PowerPoint ļ│┤ļŗż ļ╣Āļź┤Ļ▓ī ņé¼ņ¦äņØä Ļ▓░ĒĢ®ĒĢśņśĆļŗż(p<0.001) (Table 2).

Ļ░ü ņ¦łĒÖśļ│äļĪ£ HydraVersionņØś ĒÅēĻĘĀ ņåīņÜö ņŗ£Ļ░äņØĆ ļé┤ņé¼ņŗ£ 2.45 ┬▒ 0.40ņ┤ł, ņÖĖņé¼ņŗ£ 2.52 ┬▒ 0.58ņ┤ł, ļ¦łļ╣äņé¼ņŗ£ 2.24 ┬▒ 0.10ņ┤ł, Ļ░æņāüņäĀņĢłļ│æņ”Ø 2.51 ┬▒ 0.41ņ┤łņśĆļŗż. PowerPiontņØś ĒÅēĻĘĀ ņåīņÜö ņŗ£Ļ░äņØĆ ļé┤ņé¼ņŗ£ 267.7 ┬▒ 30.0ņ┤ł, ņÖĖņé¼ņŗ£ 250.7 ┬▒ 25.3ņ┤ł, ļ¦łļ╣äņé¼ņŗ£ 256.7 ┬▒ 25.7ņ┤ł, 252.9 ┬▒ 29.5ņ┤łņśĆļŗż. ļ¬©ļōĀ ņ¦łĒÖśĻĄ░ņŚÉņä£ HydraVersionņØ┤ PowerPointļ│┤ļŗż ļ╣Āļź┤Ļ▓ī ņé¼ņ¦äņØä Ļ▓░ĒĢ®ĒĢśņśĆļŗż(p=0.002, p<0.001, p<0.001, p=0.018, respectively) (Table 2).

9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØĆ ļÅÖĒ¢ź ņÜ┤ļÅÖņØä ĒÅēĻ░ĆĒĢśĻ│Ā ņłśņłĀ ņĀäĒøäņØś ņØśļ¼┤ ĻĖ░ļĪØņŚÉ ĒĢäņłśņĀüņØ┤ļéś ņØ┤ļź╝ ņ┤¼ņśüĒĢśĻ│Ā ĒĢ£ ņןņØś ņé¼ņ¦äņ£╝ļĪ£ ĒÄĖņ¦æĒĢśļŖö Ļ│╝ņĀĢļōżņØĆ ņŗ£Ļ░äņØ┤ ļ¦ÄņØ┤ ņåīļ¬©ļÉśļŖöļŹ░, ĒĢ£ ņŚ░ĻĄ¼ņŚÉ ļö░ļź┤ļ®┤ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņ┤¼ņśüĒĢśĻ│Ā PowerPointļĪ£ ĒÄĖņ¦æĒĢśļŖö ĻĖ░ņĪ┤ņØś ļ░®ļ▓ĢņØĆ ņĢĮ 515.5 ┬▒ 187.0ņ┤łĻ░Ć ņåīņÜöļÉśņŚłļŗż.15 ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ņé¼ņ¦äņØä ņ┤¼ņśüĒĢśļŖöļŹ░ Ļ▒Ėļ”¼ļŖö ņŗ£Ļ░äņØĆ ņĖĪņĀĢĒĢśņ¦Ć ņĢŖĻ│Ā, ņ┤¼ņśüļÉ£ ņé¼ņ¦äņØä ĒÄĖņ¦æĒĢśļŖö ņŗ£Ļ░äļČĆĒä░ ņĖĪņĀĢĒĢśņśĆļŗż. ĻĘĖ Ļ▓░Ļ│╝ PowerPointļĪ£ ĒÄĖņ¦æĒĢśļŖö ņłśņ×æņŚģņØĆ ņĢĮ 255.9 ┬▒ 26.7ņ┤ł, Hydra-VersionņØä ņé¼ņÜ®ĒĢ£ Ļ▓ĮņÜ░ ņĢĮ 2.40 ┬▒ 0.43ņ┤łĻ░Ć ņåīņÜöļÉśņ¢┤ ļæÉ ļ░®ļ▓Ģ Ļ░äņŚÉ Ļ▒Ėļ”¼ļŖö ņŗ£Ļ░ä ņ░©ņØ┤ļŖö ļīĆļץ 4ļČä ņĀĢļÅäņśĆļŗż. ĒĢ£ ņןņØś ņé¼ņ¦äļ¦ī ĒĢ®ņä▒ĒĢ£ļŗżļ®┤ 4ļČäņØ┤ļØ╝ļŖö ņŗ£Ļ░äņØĆ Ēü░ ļČĆļŗ┤ņØ┤ ļÉśņ¦Ć ņĢŖļŖöļŗż. ĻĘĖļ¤¼ļéś ņŗżņĀ£ ņ×äņāü ĒśäņןņŚÉņä£ļŖö ĒĢśļŻ©ņŚÉļÅä ņŚ¼ļ¤¼ ĒÖśņ×ÉņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņ┤¼ņśüĒĢśĻ▓ī ļÉśĻ│Ā, 10ļ¬ģņØś ņé¼ņ¦äņØä ĒĢ®ņä▒ĒĢ┤ņĢ╝ ļÉ£ļŗżļ®┤ ĻĖ░ņĪ┤ņØś ņłśņ×æņŚģĻ│╝ HydraVersionņØĆ 40ļČäņØś ņŗ£Ļ░ä ņ░©ņØ┤Ļ░Ć ļéśĻ▓ī ļÉ£ļŗż. ņØ┤ļ¤¼ĒĢ£ ņŗ£Ļ░ä ņ░©ņØ┤ļŖö ĒÄĖņ¦æĒĢ┤ņĢ╝ ĒĢśļŖö 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØ┤ ļ¦ÄņØäņłśļĪØ ņ╗żņ¦äļŗż. ļśÉĒĢ£ ĻĖ░ņĪ┤ņØś ņłśņ×æņŚģņØĆ ĒÄĖņ¦æņ×ÉĻ░Ć ņ¦üņĀæ ņé¼ņ¦äņØä ņäĀļ│äĒĢśĻ│Ā ĒÄĖņ¦æĒĢśļŖö ņłśĻ│ĀļĪ£ņøĆņØ┤ ņ׳ĻĖ░ļĢīļ¼ĖņŚÉ, HydraVersionņØä ņé¼ņÜ®ĒĢśļŖö Ļ▓ĮņÜ░ ĻĖ░ņĪ┤ņØś ņłśņ×æņŚģņŚÉ ļ╣äĒĢ┤ ņŗ£Ļ░äņĀü ņØ┤ļōØļ┐Éļ¦ī ņĢäļŗłļØ╝, ņØĖļĀźņĀüņØĖ ļ®┤ņŚÉņä£ļÅä ņØ┤ļōØņØä ļ│╝ ņłś ņ׳ļŗż.

ĻĘĖļÅÖņĢł ņŗ£Ļ░ä ļ░Å ņØĖļĀź ļČĆņĪ▒ņØś ņØ┤ņ£ĀļĪ£ ļ│Ė ļ│æņøÉņØä ĒżĒĢ©ĒĢśņŚ¼ ņØ╝ļČĆ ņé¼ņŗ£ ļ░Å ņŗĀĻ▓ĮņĢłĻ│╝ Ēü┤ļ”¼ļŗēņŚÉņä£ļŖö ļ¬ćļ¬ćņØś ņĢłĻĄ¼ ņé¼ņ¦äļōżņØ┤ Ļ▓░ĒĢ®ļÉśņ¦Ć ļ¬╗ĒĢśĻ│Ā ļé▒ņןņ£╝ļĪ£ ļ│┤Ļ┤ĆļÉśĻ│Ā ņ׳ņŚłļŗż. ļé▒ņןņ£╝ļĪ£ ļ│┤Ļ┤ĆļÉśļŖö ņé¼ņ¦äļōżņØĆ ĒĢ£ ņןņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņŚÉ ļ╣äĒĢ┤ņä£ ņĀäļ░śņĀüņØĖ ņČöņØ┤Ļ░Ć ĒĢ£ļłłņŚÉ ļōżņ¢┤ņśżņ¦Ć ņĢŖĻ│Ā, ĻĖ░ļĪØņ£╝ļĪ£ ļé©ĻĖĖ ļĢī ļ¦ÄņØĆ ņןņłśļź╝ ņ░©ņ¦ĆĒĢĀ ņłś ņ׳ļŗż. ļö░ļØ╝ņä£ ļé▒ņןņ£╝ļĪ£ ļ│┤Ļ┤ĆļÉśļŖö ņé¼ņ¦äļōżņØĆ ĒĢ£ ņןņØś 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņŚÉ ļ╣äĒĢ┤ņä£ ņŗ£Ļ░äņŚÉ ļö░ļźĖ ĒÖśņ×ÉņØś Ļ▓ĮĻ│╝ļź╝ ĒĢ£ļłłņŚÉ ļ╣äĻĄÉĒĢśļŖö Ļ▓āņØ┤ ņ¢┤ļĀĄĻ│Ā, ņØ╝ļČĆ ņĢłĻĄ¼ ņé¼ņ¦äļōżņØ┤ ņŚ░ĻĄ¼ ļ░Å ņ×äņāüņŚÉņä£ ĒÖ£ņÜ®ļÉśņ¦Ć ļ¬╗ĒĢśĻ│Ā ņ׳ņŚłļŗż.

ņØ┤ļ¤¼ĒĢ£ ļČłĒÄĖņØä ĒĢ┤Ļ▓░ĒĢśĻĖ░ ņ£äĒĢ┤ ĻĖ░ņĪ┤ņØś ņŚ¼ļ¤¼ ņŚ░ĻĄ¼ņŚÉņä£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ĒĢ®ņ╣śļŖö ļ░®ļ▓ĢļōżņØä Ļ│ĀņĢłĒĢśņśĆļŗż. ŌĆ£9GazeŌĆØ15ņÖĆ ŌĆ£StrabisPIXŌĆØ16ļŖö ņŖżļ¦łĒŖĖĒÅ░ņØä ņØ┤ņÜ®ĒĢśņŚ¼ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņēĮĻ▓ī ņ┤¼ņśüĒĢśĻĖ░ ņ£äĒĢ┤ Ļ│ĀņĢłļÉ£ ņ¢┤Ēöīļ”¼ņ╝ĆņØ┤ņģśņØ┤ļŗż. ļæÉ ļ░®ļ▓Ģ ļ¬©ļæÉ ĒöäļĪ£ĻĘĖļשņØ┤ ņ¦Ćņŗ£ĒĢśļŖö ļīĆļĪ£ ĒÖśņ×ÉĻ░Ć 9ļ░®Ē¢ź ļ¬©ļæÉ ņé¼ņ¦äņØä ņ┤¼ņśüĒĢśļ®┤, ĒöäļĪ£ĻĘĖļשņØĆ ņ┤¼ņśüĒĢ£ ņé¼ņ¦äļōżņØä ņ×ÉļÅÖņ£╝ļĪ£ ĒĢ®ņ│Éņä£ ĒĢ£ ņןņØś ņØ┤ļ»Ėņ¦Ćļź╝ ņāØņä▒ĒĢ£ļŗż. ņČöĻ░ĆņĀüņ£╝ļĪ£ ŌĆ£StrabisPIXŌĆØļŖö ļ│æņøÉĻ│╝ ĒśæļĀźĒĢśņŚ¼ ņāØņä▒ļÉ£ ņØ┤ļ»Ėņ¦Ćļź╝ ĒÖśņ×É ņĀĢļ│┤ņŚÉ ņŚ░Ļ▓░ĒĢśĻ│Ā ņĢłĻ│╝ ņØśņé¼ņŚÉĻ▓ī ņĀäņåĪĒĢĀ ņłś ņ׳ļŗż. ĻĘĖļ¤¼ļéś ņØ┤ ļ░®ļ▓ĢļōżņØĆ ņé¼ņ¦äņØä ĒĢ®ņ╣śļŖö Ļ│╝ņĀĢļ¦īņØä ņ×ÉļÅÖĒÖöĒ¢łĻĖ░ ļĢīļ¼ĖņŚÉ, ņ┤¼ņśüņ×ÉĻ░Ć ņłśļÅÖņ£╝ļĪ£ ņé¼ņ¦äņØä ņäĀļ│äĒĢśĻ│Ā ņé¼ņ¦äņØś Ēü¼ĻĖ░ņÖĆ ļ¬©ņ¢æņØä ļ¦×ņČ░ņĢ╝ ĒĢ£ļŗż. ļśÉĒĢ£ ĻĖ░ņĪ┤ņØś ļööņ¦ĆĒäĖ ņ╣┤ļ®öļØ╝ļĪ£ ņ┤¼ņśüĒĢ£ ņĢłĻĄ¼ ņé¼ņ¦äļōżņØĆ ļ│ĆĒÖśĒĢĀ ņłś ņŚåļŗżļŖö ĒĢ£Ļ│äĻ░Ć ņ׳ņŚłļŗż.

ņ×ÉļÅÖĒÖöļÉ£ ļ░®ļ▓Ģņ£╝ļĪ£ ņĢłĻĄ¼ ņé¼ņ¦äņØś ņŻ╝ņŗ£ ļ░®Ē¢źņØä ļČäņäØĒĢ£ ļŗżļźĖ ņŚ░ĻĄ¼ ņżæ ņØ╝ļČĆļŖö ņØ┤ļ»Ėņ¦ĆņŚÉņä£ ņĢłĻĄ¼ņØś ņ£äņ╣śļź╝ ņ░ŠļŖö Ļ│╝ņĀĢņØ┤ ņāØļץļÉśņ¢┤ ņ׳ņŚłļŗż.3,17 ļśÉĒĢ£ ņØ╝ļČĆ ņŚ░ĻĄ¼ļōżņØĆ ņ×ÉļÅÖĒÖöļÉ£ ļ░®ļ▓Ģņ£╝ļĪ£ ņĢłĻĄ¼ņØś ņ£äņ╣śļź╝ ņ░ŠĻ│Ā ņĢłĻĄ¼ ņØ┤ļ»Ėņ¦Ćļ¦ī ņČöņČ£ĒĢ£ ļŗżņØī, ļłłļÅÖņ×ÉņØś ņ£äņ╣śļź╝ ĒåĄĒĢ┤ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ņČöņĀüĒĢśļŖö ņŚ¼ļ¤¼ ĻĄ¼ļČäļÉ£ ļŗ©Ļ│äļź╝ ņłśĒ¢ēĒĢśņśĆļŗż.18,19 ņØ┤ļ¤¼ĒĢ£ ņŚ░ĻĄ¼ļōżņŚÉ ļ╣äĻĄÉĒĢ£ HydraVersionņØś ņןņĀÉņØĆ ņĢłĻĄ¼ņØś ņ£äņ╣śļź╝ ņ░ŠĻ│Ā, ņŻ╝ņŗ£ ļ░®Ē¢źņØä ļČäņäØĒĢśļŖö ņŚ¼ļ¤¼ Ļ│╝ņĀĢļōżņØä ļ¼╝ņ▓┤ ņŗØļ│ä ĻĖ░ļ▓ĢņØä ņØæņÜ®ĒĢśņŚ¼ ĒĢ£ ļ▓łņŚÉ ņłśĒ¢ēĒĢ£ļŗżļŖö ņĀÉņØ┤ļŗż. ņØ┤ļź╝ ĒåĄĒĢ┤ ĻĖ░Ļ│ä ĒĢÖņŖĄņØä ņ£äĒĢ£ ļØ╝ļ▓©ļ¦ü Ļ│╝ņĀĢņØä ĒĢ£ ļŗ©Ļ│äļĪ£ ļŗ©ņł£ĒÖöĒĢĀ ņłś ņ׳ņŚłĻ│Ā, ņĢłĻĄ¼ ņé¼ņ¦äņØä ļČäņäØĒĢśļŖö ņØ┤ļ»Ėņ¦Ć ņ▓śļ”¼ ņåŹļÅä ļśÉĒĢ£ Ļ░£ņäĀĒĢĀ ņłś ņ׳ņŚłļŗż.

ņØ┤ļ»Ėņ¦ĆņŚÉņä£ ņøÉĒĢśļŖö Ēü┤ļלņŖżļź╝ ņ░ŠļŖö ĻĖ░Ļ│äĒĢÖņŖĄ ļ░®ļ▓ĢņØĆ Ēü¼Ļ▓ī ņØ┤ļ»Ėņ¦Ć ļČäļźś(classification), ļ¼╝ņ▓┤ ņŗØļ│ä(object detection)ņ£╝ļĪ£ ĻĄ¼ļČäĒĢĀ ņłś ņ׳ļŗż. ņØ┤ ņżæ ņØ┤ļ»Ėņ¦Ć ļČäļźśļŖö ņØ┤ļ»Ėņ¦Ć ĒĢ£ ņןņŚÉ ĒĢ£ Ļ░Ćņ¦ĆņØś Ēü┤ļלņŖżļ¦ī ņĪ┤ņ×¼ĒĢ£ļŗżĻ│Ā Ļ░ĆņĀĢĒĢ£ļŗż. ņśłļź╝ ļōżņ¢┤, ņ¢┤ļ¢ĀĒĢ£ ņØ┤ļ»Ėņ¦ĆĻ░Ć ŌĆ£Ļ░ĢņĢäņ¦ĆŌĆØļĪ£ ļČäļźśļÉ£ļŗżļ®┤, ņØ┤ ņØ┤ļ»Ėņ¦ĆņŚÉļŖö Ļ░ĢņĢäņ¦Ćļ¦ī ņĪ┤ņ×¼ĒĢ┤ņĢ╝ ĒĢśļ®░ ļÅÖņŗ£ņŚÉ ŌĆ£Ļ│Āņ¢æņØ┤ŌĆØļéś ŌĆ£ĒåĀļü╝ŌĆØĻ░Ć Ļ░ÖņØ┤ ņ׳ņØä ņłś ņŚåļŗż. ņØ┤ļ¤¼ĒĢ£ ņØ┤ņ£ĀļĪ£ ņØ┤ļ»Ėņ¦Ć ļČäļźś ĻĖ░ļ▓ĢņØĆ ņ¦łļ│æņØś ņ£Āļ¼┤, ņ¦łĒÖśņØś ņóģļźśņÖĆ Ļ░ÖņØ┤ ĒĢ£Ļ░Ćņ¦Ć ļ▓öņŻ╝ļĪ£ ĻĄ¼ļČäĒĢĀ ņłś ņ׳ļŖö ļŹ░ņØ┤Ēä░ļź╝ ĻĄ¼ļČäĒĢśļŖöļŹ░ ņé¼ņÜ®ĒĢĀ ņłś ņ׳ļŗż. ņØ┤ļ»Ėņ¦Ć ļČäļźś ļ░®ļ▓Ģņ£╝ļĪ£ļŖö ĒĢ£ Ļ░£ņØś Ēü┤ļלņŖżļ¦ī ļČĆņŚ¼ĒĢśĻĖ░ ļĢīļ¼ĖņŚÉ, ņĢłĻĄ¼ ņé¼ņ¦äņØś ļæÉ ļłłņŚÉ Ļ░üĻ░ü Ēü┤ļלņŖżļź╝ ļČĆņŚ¼ĒĢĀ ņłś ņŚåļŗż.

ņĢłĻĄ¼ ņé¼ņ¦äņŚÉņä£ ņ¢æ ļłłņØä ņŗØļ│äĒĢśĻĖ░ ņ£äĒĢ┤ ļ¼╝ņ▓┤ ņŗØļ│ä ĻĖ░ļ▓ĢņØä ņé¼ņÜ®ĒĢśļŖö Ļ▓āņØĆ ņØ┤ļ»Ėņ¦Ć ļČäļźś ĻĖ░ļ▓ĢņŚÉ ļ╣äĒĢ┤ ņŚ¼ļ¤¼ ņןņĀÉņØ┤ ņ׳ļŗż. ļ¼╝ņ▓┤ ņŗØļ│äņØĆ ĒĢ£ ņןņØś ņØ┤ļ»Ėņ¦ĆņŚÉ ĒĢ£ Ļ░Ćņ¦Ć ņØ┤ņāüņØś ļ¼╝ņ▓┤(object)Ļ░Ć ņĪ┤ņ×¼ĒĢĀ ļĢī, Ļ░üĻ░üņØś ļ¼╝ņ▓┤ņØś ņ£äņ╣śņÖĆ Ēü┤ļלņŖż, ĒÖĢļźĀņØä ĻĄ¼ļČäĒĢśņŚ¼ ņČ£ļĀźĒĢ£ļŗż. ļö░ļØ╝ņä£ ļ¼╝ņ▓┤ ņŗØļ│ä ļ░®ļ▓ĢņØä ņØ┤ņÜ®ĒĢśļ®┤ ņ¢æņĢł Ļ░üĻ░üņŚÉ ļīĆĒĢ┤ ņ£äņ╣śņÖĆ Ēü┤ļלņŖż, ĒÖĢļźĀņØä ņ¢╗ņØä ņłś ņ׳ļŗż. ņ¢æņĢłņØä ļö░ļĪ£ ĒÅēĻ░ĆĒĢśĻĖ░ ļĢīļ¼ĖņŚÉ, ņé¼ņŗ£ ļ░Å ļłłņÜ┤ļÅÖņןņĢĀņŚÉ ņØśĒĢ┤ ņ¢æņĢłņØś ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ ņØ╝ņ╣śĒĢśņ¦Ć ņĢŖļŹöļØ╝ļÅä, Ļ░üĻ░üņØś ļłłņØś ņŻ╝ņŗ£ ļ░®Ē¢źņØä ļÅģļ”ĮņĀüņ£╝ļĪ£ ĒÅēĻ░ĆĒĢĀ ņłś ņ׳ļŗżļŖö ņןņĀÉņØ┤ ņ׳ļŗż. ļśÉĒĢ£ Ļ░üĻ░üņØś Ēü┤ļלņŖżņŚÉ ļīĆĒĢ£ ĒÖĢļźĀņØ┤ ņČ£ļĀźļÉśĻĖ░ ļĢīļ¼ĖņŚÉ Ļ░ÖņØĆ ļ░®Ē¢źņØä ļæÉ ļ▓ł ņØ┤ņāü ņ┤¼ņśüĒĢśļŹöļØ╝ļÅä, Ļ░Ćņן ņĀĢĒÖĢļÅäĻ░Ć ļåÆņØĆ ņé¼ņ¦äņØä ņäĀļ│äĒĢĀ ņłś ņ׳ļŗż. ļśÉĒĢ£ ņ¢æņĢłņØś ņ£äņ╣śĻ░Ć Ļ░üĻ░ü ņČ£ļĀźļÉśĻĖ░ ļĢīļ¼ĖņŚÉ ņ¢æ ļłłņØś ņ£äņ╣śļź╝ ĻĖ░ļ░śņ£╝ļĪ£ ņØ╝ņĀĢĒĢ£ ĻĘ£Ļ▓®ņ£╝ļĪ£ ņØ┤ļ»Ėņ¦Ćļź╝ ĒÜīņĀäĒĢśĻ│Ā, ņ×Éļź┤Ļ│Ā, Ēü¼ĻĖ░ļź╝ ņĪ░ņĀĢĒĢĀ ņłś ņ׳ļŗż. ļö░ļØ╝ņä£ ĻĖ░ņĪ┤ņØś ĒöäļĪ£ĻĘĖļשļōżņØ┤ ņé¼ņÜ®ĒĢśņśĆļŹś ļ░®ļ▓Ģ15,16ņ▓śļ¤╝ ņé¼ņ¦äņØä ņØ╝ņĀĢĒĢ£ ĒśĢĒā£ļĪ£ ņ┤¼ņśüĒĢśņ¦Ć ņĢŖļŹöļØ╝ļÅä, ĒöäļĪ£ĻĘĖļשņØ┤ ņ×ÉļÅÖņ£╝ļĪ£ ņĢłĻĄ¼ ņ£äņ╣śļź╝ ņØĖņŗØĒĢśņŚ¼ ņĀĢĒĢ┤ņ¦ä Ēü¼ĻĖ░ņÖĆ Ļ░üļÅä, ļ¬©ņ¢æņØä ļ¦×ņČöņ¢┤ ĒÄĖņ¦æĒĢĀ ņłś ņ׳ņŚłļŗż.

ņ¦łĒÖśņŚÉ ļö░ļØ╝ ņé¼ņŗ£ ļ░Å ļłłņÜ┤ļÅÖņןņĢĀņØś ĒśĢĒā£Ļ░Ć ļŗżņ¢æĒĢśļ®░, Ļ░üĻ░üņØś ļłłņØĆ ļ╣äņĀĢņāüņĀüņØĖ ņ£äņ╣śļź╝ Ļ░Ćņ¦ł ņłś ņ׳Ļ│Ā, ņä£ļĪ£ ļŗżļźĖ ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢĀ ņłśļÅä ņ׳ļŗż. ņØ┤ņŚÉ ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖļĪ£ ļé┤ņé¼ņŗ£, ņÖĖņé¼ņŗ£, ļ¦łļ╣äņé¼ņŗ£, ņĀ£ĒĢ£ņé¼ņŗ£ļĪ£ ņ¦łļ│æĻĄ░ņØä ļéśļłäņ¢┤ ņåīņÜöļÉśļŖö ņŗ£Ļ░äĻ│╝ ņä▒Ļ│ĄļźĀņØä ļ╣äĻĄÉĒĢśņśĆļŗż. ņØ┤ ņżæ ņĀ£ĒĢ£ņé¼ņŗ£ļŖö Ļ░æņāüņäĀ ņĢłļ│æņ”ØņØä ĒżĒĢ©ĒĢśņśĆļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ Ļ│ĀņĢłĒĢ£ HydraVersionņØĆ ļäż ņ¦łļ│æĻĄ░ ļ¬©ļæÉ ņä▒Ļ│ĄļźĀņØ┤ ļåÆņĢśļŗż. ņØ┤ļŖö ņäĀļ│äĻĖ░ņŚÉņä£ ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ Ļ░Ćņן ļ¬ģĒÖĢĒĢ£ ņé¼ņ¦äļČĆĒä░ ļ©╝ņĀĆ ļ░░ņ╣śĒĢśĻ│Ā, ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ ņĢĀļ¦żĒĢ£ ņé¼ņ¦äņØĆ ļéśņżæņŚÉ ņ▒äņøī ļäŻņØĆ ļ░®ļ▓ĢņØä ņé¼ņÜ®ĒĢśņśĆĻĖ░ ļĢīļ¼ĖņØ┤ļŗż. ļśÉĒĢ£, ņé¼ņŗ£ Ļ░üļÅäĻ░Ć Ēü¼Ļ▒░ļéś ļłłņÜ┤ļÅÖņØ┤ ņóŗņ¦Ć ņĢŖņØĆ Ļ▓ĮņÜ░ņŚÉļÅä ņÜ░ņłśĒĢ£ Ļ▓░Ļ│╝ļź╝ ļ│┤ņŚ¼ņŻ╝ņŚłļŗż. ņØ┤ļŖö HydraVersionņØ┤ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ĒīÉļÅģĒĢĀ ļĢī ĒÖĢļźĀņØä ņé¼ņÜ®ĒĢśņśĆĻĖ░ ļĢīļ¼ĖņØ┤ļŗż. Ļ░üĻ░üņØś ņĢłĻĄ¼ ņé¼ņ¦äņØĆ 9ļ░®Ē¢źņŚÉ Ļ░üĻ░ü ņĀüĒĢ®ĒĢĀ ĒÖĢļźĀņØä ņČ£ļĀźĒĢĀ ņłś ņ׳ļŗż. ļ¦īņĢĮ ĒĢ£ ļłłņØ┤ ļ¬ģĒÖĢĒĢśĻ▓ī ĒĢ£ ļ░®Ē¢źņØä ņŻ╝ņŗ£ĒĢ£ļŗżļ®┤ ļ¦żņÜ░ ļåÆņØĆ ĒÖĢļźĀ Ļ░ÆņØä Ļ░Ćņ¦ĆĻ▓ī ļÉśĻ│Ā, ņĢĀļ¦żĒĢ£ ļ░®Ē¢źĻ│╝ Ļ░üļÅäļĪ£ ņŻ╝ņŗ£ĒĢ£ļŗżļ®┤ ļé«ņØĆ ĒÖĢļźĀ Ļ░ÆņØä Ļ░Ćņ¦ĆĻ▓ī ļÉ£ļŗż. ļö░ļØ╝ņä£ ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ ļ¬ģĒÖĢĒĢ£ ļłłņØ┤ ņĄ£ņóģņĀüņØĖ ņŻ╝ņŗ£ ļ░®Ē¢źņØä Ļ▓░ņĀĢĒĢśĻĖ░ ļĢīļ¼ĖņŚÉ, ņé¼ņŗ£Ļ░üņØ┤ Ēü¼ļŹöļØ╝ļÅä ņśüĒ¢źņØä ņĀüĻ▓ī ņŻ╝Ļ▓ī ļÉ£ļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ņĀ£ņŗ£ĒĢ£ HydraVersionņØś ĒĢ£Ļ│äņĀÉņØĆ ņ▓½ņ¦ĖļĪ£ ņé¼ņ¦äņŚÉņä£ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ĒīÉļŗ©ĒĢśĻĖ░ ņ¢┤ļĀżņÜ┤ Ļ▓ĮņÜ░ ņśżņ×æļÅÖĒĢ£ļŗżļŖö ņĀÉņØ┤ļŗż. ņłśļÅÖņ£╝ļĪ£ ņé¼ņ¦äņØä ĒĢ®ņ╣Ā ļĢīņŚÉļŖö ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ ļ¬ģĒÖĢĒĢśņ¦Ć ņĢŖļŹöļØ╝ļÅä, Ēä▒ņØś ļ░®Ē¢źņØ┤ļéś ļłłĻ║╝ĒÆĆ ņ£äņ╣ś, ņ┤¼ņśüĒĢ£ ņé¼ņ¦äņØś ņäĀĒøäĻ┤ĆĻ│ä ļō▒ ņŻ╝ļ│Ć ņĀĢļ│┤ļź╝ ņØ┤ņÜ®ĒĢ┤ņä£ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ņČöņĀĢĒĢĀ ņłś ņ׳ļŗż. ĻĘĖļ¤¼ļéś HydraVersionņØĆ ĒŖ╣ņĀĢ ņ£äņ╣śļź╝ ņŻ╝ņŗ£ĒĢśļŖö ņĢłĻĄ¼ļ¦īņØä ņØ┤ņÜ®ĒĢ┤ņä£ ņŻ╝ņŗ£ ļ░®Ē¢źņØä ĒīÉļŗ©ĒĢśĻĖ░ ļĢīļ¼ĖņŚÉ, ņŻ╝ļ│Ć ņĀĢļ│┤ļź╝ ņØ┤ņÜ®ĒĢĀ ņłś ņŚåļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ļłłĻ║╝ĒÆĆņØ┤ ļÅÖĻ│ĄņØä Ļ░Ćļ”¼Ļ▒░ļéś ņé¼ņ¦äņØś ņ┤łņĀÉņØ┤ ļ¦×ņ¦Ć ņĢŖņĢä ņŻ╝ņŗ£ ļ░®Ē¢źņØ┤ ļ¬ģĒÖĢĒĢśņ¦Ć ņĢŖņØĆ Ļ▓ĮņÜ░ HydraVersionņØ┤ ņĢłĻĄ¼ļź╝ ņ░Šņ¦Ć ļ¬╗ĒĢśĻ│Ā ņלļ¬╗ļÉ£ ņØ┤ļ»Ėņ¦Ćļź╝ ņāØņä▒ĒĢśņśĆļŗż. ļö░ļØ╝ņä£ 9ļ░®Ē¢ź ņé¼ņ¦äņØä ņ┤¼ņśüĒĢĀ ļĢī ņØ╝ņĀĢ ņłśņżĆ ņØ┤ņāüņØś ĒÆłņ¦łņØ┤ ņÜöĻĄ¼ļÉ£ļŗż. ļæśņ¦ĖļĪ£ HydraVersionņØĆ ļÅÖĒ¢źņÜ┤ļÅÖņØś ļ░®Ē¢źļ¦ī ĒÅēĻ░ĆĒĢ£ļŗż. ļö░ļØ╝ņä£ HydraVersionņØä ĒåĄĒĢ┤ņä£ļŖö ņé¼ņŗ£ņØś ņóģļźś, ņé¼ņŗ£Ļ░üņØś ļ│ĆĒÖö ļō▒ņØś ņĀĢļ│┤ļź╝ ņ¢╗ņØä ņłś ņŚåļŗż. ļ¦īņĢĮ ņé¼ņŗ£ņØś ņ¦äļŗ©ņØ┤ļéś ņé¼ņŗ£Ļ░üņØś ņĀĢļ¤ēņĀüņØĖ ĒÅēĻ░Ćļź╝ ņ£äĒĢ£ļŗżļ®┤, ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ņé¼ņÜ®ĒĢ£ 9Ļ░£ņØś Ēü┤ļלņŖżļ│┤ļŗż ļŹö ņäĖļ░ĆĒĢ£ Ēü┤ļלņŖż ĻĄ¼ļČäņØ┤ ĒĢäņÜöĒĢĀ Ļ▓āņØ┤ļŗż. ņČöĻ░ĆņĀüņØĖ ņŚ░ĻĄ¼ļź╝ ĒåĄĒĢ┤ 9ļ░®Ē¢ź ņé¼ņ¦äņØä ņ×ÉļÅÖņ£╝ļĪ£ ņāØņä▒ĒĢśļ®┤ņä£ ļÅÖĒ¢źņÜ┤ļÅÖ ņØ┤ņāüņØä ņĀĢļ¤ēņĀüņ£╝ļĪ£ ĒÅēĻ░ĆĒĢĀ ņłś ņ׳ļŖö ĒöäļĪ£ĻĘĖļשņØä Ļ░£ļ░£ĒĢ£ļŗżļ®┤, ņ×äņāüņŚÉņä£ ņé¼ņŗ£ņØś ņ¦äļŗ© ļ░Å ņé¼ņŗ£Ļ░üņØś ņĀĢļ¤ēņĀüņØĖ ĒÅēĻ░ĆņŚÉ ļŹö ļ¦ÄņØĆ ļÅäņøĆņØ┤ ļÉĀ Ļ▓āņØ┤ļŗż. ļśÉĒĢ£ ĻĖ░ņĪ┤ņØś ņŚ░ĻĄ¼ļÉ£ 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦ä ņ¢┤Ēöīļ”¼ņ╝ĆņØ┤ņģś15,16Ļ│╝ Ļ▓░ĒĢ®ĒĢśņŚ¼ HydraVersionņØä ņØ╝ļ░śņØĖļÅä ņé¼ņÜ®ĒĢśĻĖ░ ņēĮĻ▓ī Ļ│ĀņĢłĒĢ£ļŗżļ®┤, ļ│æņøÉ ļ░®ļ¼ĖņØ┤ ĒלļōżĻ▒░ļéś ĒśæņĪ░Ļ░Ć ļČĆņĪ▒ĒĢ£ ĒÖśņ×ÉņŚÉņä£ļÅä ņ¦äļŻī ļ░Å ņ╣śļŻīņŚÉ ļÅäņøĆņØä ļ░øņØä ņłś ņ׳ņØä Ļ▓āņØ┤ļØ╝ ĻĖ░ļīĆĒĢ£ļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖņØś ņłśĻ░Ć ņĢĮ 1,700ņןņ£╝ļĪ£, Ļ░ü Ēü┤ļלņŖżļ¦łļŗż 200ņŚ¼ ņן ņĀĢļÅäļ░¢ņŚÉ ļ░░ņĀĢļÉśņ¦Ć ņĢŖņĢä ņłśĻ░Ć ļČĆņĪ▒ĒĢśņśĆļŗż. ĻĘĖļלņä£ HydraVersionņØĆ ņĄ£ļīĆĒĢ£ ņŗØļ│ä ļŖźļĀźņØä ļüīņ¢┤ļé┤ĻĖ░ ņ£äĒĢ┤ Ļ░Ćņן Ēü¼Ļ│Ā ļ│Ąņ×ĪĒĢ£ ļ¬©ļŹĖņØä ņé¼ņÜ®ĒĢĀ ņłśļ░¢ņŚÉ ņŚåņŚłļŗż. ņČöĒøä ļŹö ļ¦ÄņØĆ ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņäĖĒŖĖļź╝ ņØ┤ņÜ®ĒĢśĻ│Ā ņé¼ņ¦äņØś ĒĢ┤ņāüļÅäņÖĆ ņ▒äļÅäļź╝ ļ×£ļŹżņ£╝ļĪ£ ļ│ĆĻ▓ĮĒĢśņŚ¼ ļŹ░ņØ┤Ēä░ņäĖĒŖĖņØś ņłśļź╝ ļŖśļ”░ļŗżļ®┤, ļŹö ļ╣Āļź┤Ļ│Ā Ļ░Ćļ▓╝ņÜ┤ ļ¬©ļŹĖļĪ£ļÅä Ļ░ÖņØĆ ņä▒ļŖźņØä ļ░£Ē£śĒĢĀ ņłś ņ׳ņØä Ļ▓āņØ┤ļŗż. ļśÉĒĢ£, ĒÅēĻ░Ć ļŹ░ņØ┤Ēä░ņäĖĒŖĖņØś ņłśļÅä 74ņןņ£╝ļĪ£ Ļ░ü ņ¦łĒÖśļ│äļĪ£ ļ░░ņĀĢļÉ£ ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖņØś ņłśĻ░Ć ļČĆņĪ▒ĒĢśņśĆļŗż. ņČöĒøä ļŹö ļ¦ÄņØĆ ĒÅēĻ░ĆļŹ░ņØ┤Ēä░ņäĖĒŖĖļź╝ ņØ┤ņÜ®ĒĢ£ļŗżļ®┤, ņé¼ņŗ£Ļ░üņØ┤ Ēü░ ņÖĖņé¼ņŗ£ļéś ļé┤ņé¼ņŗ£ ļśÉļŖö ļłłņÜ┤ļÅÖņןņĢĀĻ░Ć ņŗ¼ĒĢ£ ļ¦łļ╣äņé¼ņŗ£ ļō▒ņ£╝ļĪ£ ņ¦łĒÖśņØä ļŹö ņäĖļČäĒÖöĒĢśĻ│Ā Ļ░üĻ░üņØś ņåīņÜö ņŗ£Ļ░äĻ│╝ ņä▒Ļ│ĄļźĀņØä ļ╣äĻĄÉĒĢśņŚ¼ ļČäņäØĒĢśļŖö Ļ▓āņØ┤ ĒĢäņÜöĒĢśļŗż.

ļ│Ė ņŚ░ĻĄ¼ļź╝ ĒåĄĒĢ┤ ņØĖļĀźĻ│╝ ņŗ£Ļ░äņØ┤ ļ¦ÄņØ┤ ņåīļ¬©ļÉśļŖö 9ļ░®Ē¢ź ņĢłĻĄ¼ ņé¼ņ¦äņØä ņ×ÉļÅÖĒÖöļÉ£ ļ░®ļ▓Ģņ£╝ļĪ£ ļ╣Āļź┤Ļ▓ī ņāØņä▒ĒĢĀ ņłś ņ׳Ļ▓ī ļÉ©ņŚÉ ļö░ļØ╝ ņé¼ņŗ£ ļ░Å ņŗĀĻ▓ĮņĢłĻ│╝ ĒÖśņ×ÉņØś ņ¦äļŗ©, ņ╣śļŻī ļ░Å ņŚ░ĻĄ¼ņŚÉ ļÅäņøĆņØ┤ ļÉĀ ņłś ņ׳ņ£╝ļ”¼ļØ╝ ĻĖ░ļīĆļÉ£ļŗż.

Figure┬Ā1.

Overview of machine learning-based Auto-merge program (HydraVersion) for nine-directional ocular photography. The HydraVersion consists of the discriminator, the selector, and the editor. The discriminator uses machine learning to interpret the position and gaze direction of the eye in the photographs. The selector selects one eye photograph in each direction of nine-directional ocular photography based on the gaze direction of the eye interpreted by the discriminator. The editor rotates, resizes, and crops the periphery of the photograph according to eye position, arranges it in the proper size and place, and combines it to create a single nine-directional ocular photography.

Figure┬Ā2.

Detailed mechanisms of HydraVersion. After machine learning, the discriminator receives multiple eye photographs and outputs an identification result table, including the eyeŌĆÖs position, class, and score. The selector gets the identification result table, draws up a nine-direction scorecard, and selects eye photographs in the order of the most probabilities. The editor receives the identification result table from the discriminator and the 9-direction scorecard from the selector. The editor converts the eye photographs into a standardized format using the eye positions in the identification result table. After that, the editor arranges the edited images at each part of the 9-directional ocular photographs based on the 9-direction scorecard received from the selector and combines them to create a single image.

Table┬Ā1.

The accuracy of HydraVersion

|

Interpreting accuracy* |

Merging accuracyŌĆĀ |

|||||

|---|---|---|---|---|---|---|

| Total | Error | Accuracy (%) | Total | Error | Accuracy (%) | |

| Esotropia | 116 | 2 | 98.28 | 12 | 0 | 100.0 |

| Exotropia | 290 | 11 | 96.21 | 28 | 2 | 92.86 |

| Paralytic strabismus | 246 | 1 | 99.59 | 27 | 1 | 96.30 |

| TAO | 76 | 5 | 93.42 | 7 | 0 | 100.0 |

| Total | 728 | 19 | 97.39 | 74 | 3 | 95.95 |

Table┬Ā2.

Comparison of the time required between the HydraVersion and PowerPoint

| Esotropia | Exotropia | Paralytic strabismus | TAO | Total | |

|---|---|---|---|---|---|

| HydraVersion | 2.45 ┬▒ 0.40 | 2.52 ┬▒ 0.58 | 2.24 ┬▒ 0.10 | 2.51 ┬▒ 0.41 | 2.40 ┬▒ 0.43 |

| PowerPoint | 267.7 ┬▒ 30.0 | 250.7 ┬▒ 25.3 | 256.7 ┬▒ 25.7 | 252.9 ┬▒ 29.5 | 255.9 ┬▒ 26.7 |

| p-value* | 0.002 | <0.001 | <0.001 | 0.018 | <0.001 |

REFERENCES

1) Von Noorden G, Campos E. Binocular Vision and Ocular Motility: Theory and Management of Strabismus, 6th ed. St. Louis, MO: Mosby Year Book. Inc, 2002;68-9.

2) Khan MQ, Lee S. Gaze and eye tracking: techniques and applications in ADAS. Sensors (Basel) 2019;19:5540.

3) de Figueiredo LA, Dias JVP, Polati M, et al. Strabismus and artificial intelligence app: optimizing diagnostic and accuracy. Transl Vis Sci Technol 2021;10:22.

4) Lim HW, Lee DE, Lee JW, et al. Clinical measurement of the angle of ocular movements in the nine cardinal positions of gaze. Ophthalmology 2014;121:870-6.

5) Zou Z, Chen K, Shi Z, et al. Object detection in 20 years: a survey. arXiv 2019 May 16 doi: 10.48550/arXiv.1905.05055.

6) Blascheck T, Kurzhals K, Raschke M, et al. Visualization of eye tracking data: a taxonomy and survey. Comput Graph Forum 2017;36:260-84.

7) Niehorster DC, Cornelissen THW, Holmqvist K, et al. What to expect from your remote eye-tracker when participants are unrestrained. Behav Res Methods 2018;50:213-27.

8) Van Renswoude DR, Raijmakers MEJ, Koornneef A, et al. Gazepath: an eye-tracking analysis tool that accounts for individual differences and data quality. Behav Res Methods 2018;50:834-52.

9) Sharma P, Joshi S, Gautam S, et al. Student engagement detection using emotion analysis, eye tracking and head movement with machine learning. In: Reis A, Barroso J, Martins P, et al., eds. Technology and Innovation in Learning, Teaching and Education. Cham: Springer, 2022; chap. 5.

10) Pulli K, Baksheev A, Kornyakov K, Eruhimov V. Real-time computer vision with OpenCV. Commun ACM 2012;55:61-9.

11) Van Der Walt S, Colbert SC, Varoquaux G. The NumPy array: a structure for efficient numerical computation. Comput Sci Eng 2011;13:22-30.

12) Abadi M, Barham P, Chen J, et al. TensorFlow: a system for Large-Scale machine learning. In: USENIX, eds. Graph Processing and Machine Learning. 12th USENIX Symposium on Operating Systems Design and Implementation; 2016 Nov 2-4; Savannah, GA. Berkeley, CA: USENIX Association; 2016. p.265-84.

13) Tan M, Pang R, Le QV. Efficientdet: Scalable and efficient object detection. In: IEEE, eds. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR); 2020 Jun 13-19; Seattle, WA. Manhattan, NY: IEEE; 2020. p.10778-87.

14) Tan M, Le Q. Efficientnet: Rethinking model scaling for convolutional neural networks. In: Chaudhuri A, Salakhutdinov R, eds. Proceedings of the 36th International Conference on Machine Learning; 2019 Jun 9-15; Long Beach, CA. PMLR; 2019. p.6105-14.

15) Goseki T, Kunimi K, Shioya N, et al. New device for taking ninedirectional ocular photographs:ŌĆ£9GazeŌĆØ application. J Eye Mov Res 2022 Mar 6 doi: 10.16910/jemr.15.1.5.

16) Phanphruk W, Liu Y, Morley K, et al. Validation of StrabisPIX, a mobile application for home measurement of ocular alignment. Transl Vis Sci Technol 2019;8:9.

17) Iwata Y, Handa T, Ishikawa H. Objective measurement of nine gaze-directions using an eye-tracking device. J Eye Mov Res 2020 Oct 6 doi: 10.16910/jemr.13.6.4.

18) Lu J, Fan Z, Zheng C, et al. Automated strabismus detection for telemedicine applications. arXiv 2018 Dec 3 doi: 10.48550/arXiv. 1809.02940.

PDF Links

PDF Links PubReader

PubReader ePub Link

ePub Link Full text via DOI

Full text via DOI Download Citation

Download Citation Print

Print